proj156 一种基于Linux系统运行Android 11的解决方案

高校队伍:广东东软学院 Bitcomet队

项目成员:邹明燊、田梓汎、张阳彬

指导教师:刘翠莲、罗泉

1. 项目简介

1.1 目标描述

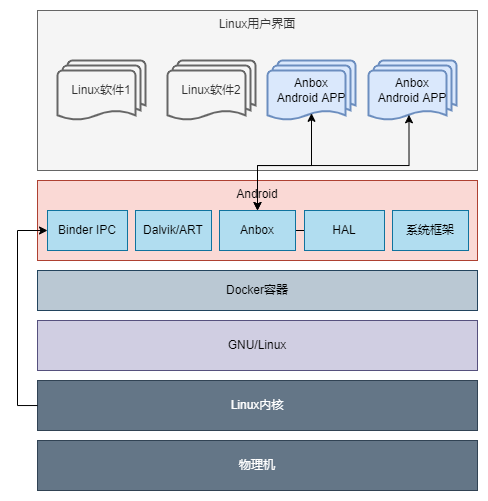

本项目目标在现有Anbox实现Android 7在Linux平台正常运行的基础上将其进一步完善,实现Android11在Linux(Ubuntu20.04)平台上的运行,还可根据用户需求下载并正常运行第三方软件。Anbox(Android in a box)是一个基于容器的方法,可以在普通的 GNU/Linux 系统上启动完整的 Android 系统。它将Android应用放进密封的容器中,无需直接访问硬件或数据,所有硬件或数据的访问都是通过与主机上的Anbox守护进程进行的。由于Anbox 直接跑在硬件上,没有软件模拟层,无需虚拟化硬件即可运行 Android,因此可以无缝桥接硬件加速功能。

本项目主要基于Anbox来参考实现,旨在完成以下四个目标:

-

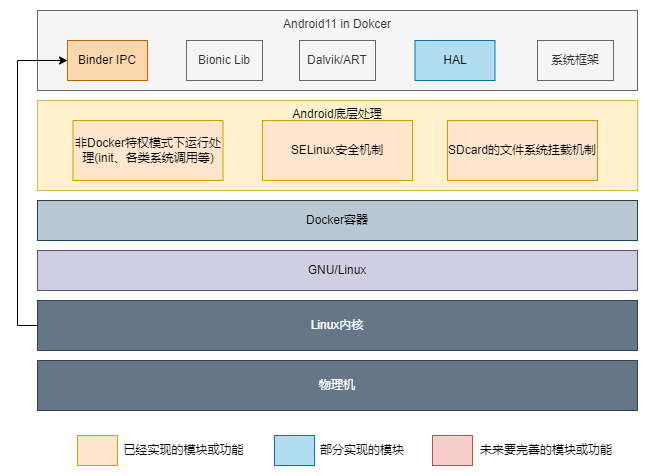

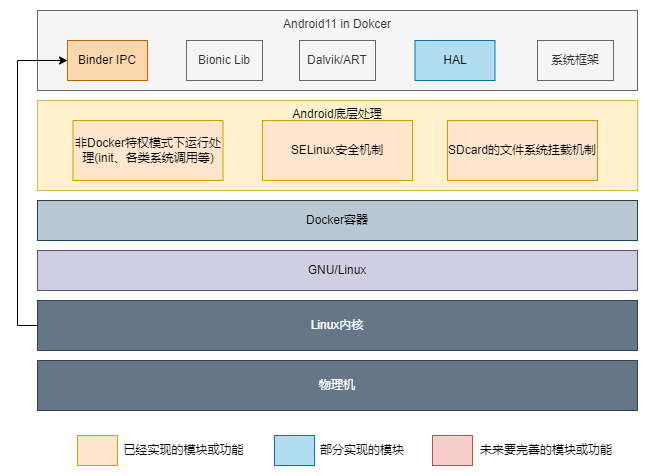

目标1:完成针对Android11的SDcard的文件系统挂载机制、SELinux安全机制、非特权模式下运行处理对应在Docker容器环境内的处理。

-

目标2:配置安卓项目工程,实现并配置好各个需要的系统模块和AIDL、HIDL、HAL模块,搭建初步调试与测试的Demo1版本,使用adb配合Scrcpy对内部Android远程访问以方便有个初步预期,并且方便本项目有个初步测试的环境。

-

目标3:完成Anbox通信部分实现向Android 11的移植,使Android能与Anbox外部实现跨系统环境通信。

-

目标4:完成Anbox其余部分的各个模块移植,使Android的三个基础部分OpenGL、HWC图形输出、键鼠输入能正常工作。

目前,我们的赛题目标完成度如下:

表1.1 赛题完成度 目标编号 基本完成情况 额外说明 1 基本完成(≈85%) 1. 与SDcard以及SELinux组件相关的Android 11的基本功能、SDcard文件管理、安装第三方软件、闹铃与联系人等基础应用测试均通过。

2. 非特权模式仅做了部分处理,未进行测试。2 基本完成(≈90%) 1. 搭建好相关容器,进行相关基础测试并通过。

2. 目前网络部分由于在Docker特权模式下运行,可能会有Bug。3 初步完成(≈80%) 1. 完成跨系统环境通信,安卓中Anbox的相关模块可以使用QEMU_PIPE(实际容器中是没有QEMU设备,Anbox实际用了Unix Domain Socket代替,但其通信的相关通道仍然叫做QEMU PIPE)进行通信或者使用Anbox实现的RPC调用。

2. Anbox的OpenGL ES的emulation库实现初步测试能通过该通信创建QEMU_PIPE连接,实现RPC调用获取到主机侧支持的OpenGL信息。

3. 由于各个部分的模块暂未完全移植好,还需要全部移植才能测试所有功能。4 初步测试(≈60%) 1. 已经把相应的Anbox的各个模块的移植到Android中,其中GPS与Audio模块使用了谷歌给Goldfish的实现。

2.OpenGL ES实现和HWC实现在Android 11下无法测试,由于Android 11的相关变动,导致输出画面调用了Gralloc的PostFB去输出,而在Anbox中是未做这部分RPC调用的,输出画面失败。

3.把相关方案在Android 10上进行测试,测试可以输出画面,但卡在安卓Launcher第一屏画面。总计 ≈80% 1. 本项目自立项以来经历了三个月的时间进行研究与开发,实现方案的过程中遇到困难重重,主要遇到的阻力在系统庞大、相关实现的资料缺失方面。

2. 目前还有部分的工作需要测试和完成。由于Android 11在图形和音频方面变动较大,即使目前进行了相关模块的移植,但是还需要在图形模块、音频模块、输入模块方面进行各类测试和调试工作。

3. 项目将放在Github进行公开,把截至目前学习的成果公开,希望后续有更多的参与者参与进来进行开发完善。

1.2 比赛题目分析和相关资料调研

1.2.1 题目分析

(1). 题目旨在实现在Linux运行Android11的解决方案,在Linux上基于容器技术隔离一个环境运行Android,其运行机制是直接基于宿主机内核下运行Android,其运行效率非常高效,对系统资源占用和运算资源的损耗都极低。

(2). 在所有实现方案中,选定了基于Anbox的实现方式。由于现今用户使用的软件硬件环境不统一,Mesa 3D等实现方式对图形处理硬件的支持有限,用户的图形环境不一定是Wayland而是X11偏多。同时考虑到可能未来需要在各类国产主机运行架构不统一(Arm、x86、MIPS、LoongArch等架构),Anbox对于不同系统不同硬件的兼容性优势使得其是现有方案中最合适的。

(3). 在实现过程中,考虑到Anbox的LXC也是比较老的容器架构,同时其集成LXC的操作不利于后续容器核心升级、配置调整、在线镜像更新和镜像快速部署等,所以使用Docker来支撑其Android的运行环境,对比最初的LXC方案来说拥有更高的灵活性和可靠性。

(4). 项目计划是初期构建调整好Android高版本核心跑起一个基于Docker容器实现的Demo,后续逐步移植剩余Anbox组件到Android11上。

1.2.2 资料调研

现有方案

(1). Anbox:基于LXC容器运行Android 7,利用QEMU pipe实现Android与Anbox上层Linux软件用户接口进行通信。其通信中输入的数据包括:接收传入的传感器数据,接收用户鼠标点击和触摸事件,接收APP启动和窗口调整数据、Anbox上层软件屏幕缓冲区的可选回传等;通信中输出的数据则包括:传输Android上2D图形画面和OpenGL的渲染指令到Linux环境中渲染、传输音频输出数据。Anbox运行Android的机制的实现方式就是通过将Android内必要的输入输出交给外部Linux环境处理,其实现接口均通过软件实现,这样对于兼容性容易出现问题的OpenGL加速部分尤为友好。但是也正因为如此,虽然保证了其兼容性,但是其支持的OpenGL库选择就非常有限,目前仅支持OpenGL ESv2,性能和稳定性会较为一般。总结其优点就是对于各类操作系统兼容性好,外部有D-Bus和OpenGL环境基本就能正常运行,缺点是通过QEMU pipe传输到外部渲染的方式,其模拟的库只支持OpenGL ESv2,稳定性一般,性能也比较逊色。

(2). Waydroid: 基于Anbox繁衍而来的实现方案,Anbox除了2018年后面稍微更新了下支持Snap和Anbox Cloud外,实现的方案已经多年未进行更新,核心无较大变化,所支持的最新Android系统仍然是2016年11月24日发布的Android 7.1.1。因此Waydroid应运而生,其前身是基于Anbox的中期版本,基于重建脚本、更新的LXC3、Mesa 3D、最新的Android8-11版本、去掉Anbox代码,后续演化后改名Waydroid。Waydroid更加新颖和完善,其优势在于最新的Android、直接通过Mesa 3D驱动显卡、支持Wayland环境;缺点是只支持Wayland,Mesa 3D作为开源驱动,只支持部分显卡。

(3). 其他方案:xDroid、Kydroid、KMRE等第三方闭源方案:xDroid和Kydroid也是类似Anbox的方式,其核心原理仍然是通过容器技术让Android直接运行在Linux上,以Linux原生程序运行,由于其闭源,能够了解的公开信息不多。KMRE从其论文1来看是类似Waydroid的Mesa3D加速的方案,其性能损耗低,但其一大特色优点在于其对接了现在国产系统常见的Xorg环境下的桌面环境,同时做好支持触摸、优化各类输入输出、传感器等的实现,对比以上开源项目,KMRE不但只实现了基本需求,而且在人性化交互等方面,易用性更高。

| 现有方案 | 优点 | 缺点 |

|---|---|---|

| Anbox | 对各类环境兼容性好、原生运行速度快 | 稳定性一般、其所支持的Android版本比较老旧、且Android内只支持OpenGL ESv2,图形化API老旧 |

| waydroid | 最新Android、支持Wayland、直接驱动显卡 | 只支持Wayland图形环境、Mesa 3D开源驱动只支持部分显卡,兼容性一般 |

| 其他闭源方案 | 闭源或商用的项目在用户交互等方面做到了更优,易用性更高 | 闭源,能查到公开的信息不多 |

项目需求和状况

(1). 项目现状:

由于西方加速技术封锁的态势,我们必须迫切的找到相应的替代方案来给国内用户有选择的权利。虽然国产Linux系统目前在飞速发展,但其应用生态紧缺,甚至一个输入法、Linux版的QQ这种基础性应用都Bug百出,使用体验极其糟糕,导致用户普及度始终不能有明显的上涨,用户也不情愿使用国产Linux作为替代系统。

因此我们需要一些中期可替代性方案,Linux上部署安卓这一个想法应运而生,我们可以利用安卓作为一个暂时的方案来承载现在的业务需求例如办公,视频通话等。安卓在2020年的中国移动操作系统市场份额占比达75.98%,相当于每4个使用智能手机的人中就有3名安卓用户。因其用户整体基数大,所以针对安卓应用开发者非常多,面对安卓延申出来的各种业务层出不穷,整个生态对于国产Linux有很大的优势。

我们可以直接借助这个优势,在Linux上运行安卓系统,完成国产Linux跟安卓生态的整合,进而发展国产Linux,并对其产生助力。而同期也比较少同类型的厂商成功实现在GNU/Linux系统中运行着整个Android系统,市场上有空缺的需求等待填补,我们的项目就是要针对这个市场的空缺,成功实现在Linux系统中运行Android系统而不是单纯的模拟,为我们之后国产Linux和国内安卓的生态整合打下坚实的基础。

(2). 项目需求:

单纯的Linux无法成功运行安卓系统中的各种应用程序,因为安卓在Linux层面上主要增加了ART虚拟机和其Application Framework框架,以及其他细枝末节的修改和优化。我们的项目需求就是需要通过一个安卓中间层在Linux上提供安卓运行环境,使安卓当中的应用程序也可以运行在我们所配置的容器当中。但是却不是以模拟器的方式,而是使用当前Linux内核基于容器技术隔离来运行安卓系统,不需要大量的软件模拟,又保证了安全性。

我们选择了这种方案,对各类硬件资源可以被无缝桥接,让性能的效率损失降到比较低的水准,完全可以满足我们日常需求。该方案补充了当前国产Linux应用生态,可以实现国产Linux操作系统应用生态不足的前提下需要快速扩充用户数量的愿景,让国产Linux操作系统走入平民百姓家。

2. 参考资料

- KMRE: An Efficient and Compatible Runtime to Execute Android Application on Linux System, [Date of Conference: 10-13 December 2021]. 10.1109/ICCC54389.2021.9674681

- Anbox(所有项目仓库): https://github.com/anbox

- 安卓AOSP源码获取来自清华大学开源软件镜像站点

1.1 方案设计

此项目基于原有Anbox方案进行更新及改进。我们改进使用基于Docker容器技术提供隔离的、与Linux并行运行的安卓环境,此种改进是对原有LXC容器的更优替代。但是该改进需要重新适配与调试,需要大量移植与测试的工作量才能保证维持原有稳定性,并更好地利用更多的新特性开发新的功能。除此之外更新新的Android 11替代原有Android 7,此过程需要重新移植原有Anbox的各个组件适配新安卓上的HIDL接口。同时需要修改Android底层,经过大量的移植和测试的工作,让其能正常运行在Docker容器中。此项目利用Anbox部分现成的模块,在Linux下上层APP实现与安卓底层对接输入输出和OpenGL ES的渲染等实现。这些设计目标在于使用Docker替代原有Anbox使用的较旧的LXC容器技术,并更新其Android 7到Android 11,其中技术革新点如下:

(1). 使用更新的Android 11替代原有老旧的Android 7。

(2). Android 11中的HAL层使用了HIDL接口这一新的Treble的架构,更加规范及更高的可移植性。

(3). 使用生态丰富、快速部署、可移植、更加可控的Docker作为底层容器运行环境替代原有集成LXC这一高耦合、低可移植性的实现方式。

(4). 活用成熟的Anbox部分对多平台高兼容性的实现方式,以应对目前国产系统多种硬件平台和系统环境的问题。

在以上的设计方案下,我们针对其各个部分进行详细设计,详细方案见“Bitcomet设计文档”。

(1). 底层部分:Docker下的安卓11容器设计:

• 高可移植设计:使用了Docker便集成了Docker相关的优点,Docker相比原有LXC有可移植性、版本控制、回滚、快速部署等优点。同时原有LXC容器与Anbox进行了高度集成,在目前多平台和可移植性考量下,原有Anbox的系统镜像与各个配置选项都不能方便地进行更改,这将会导致我们适配到国产系统中遇到重重困难。

• 快速迭代更新:使用Docker提供底层容器运行环境,利用其快速部署的优点,可以使Android 11更加灵活地运行在目标平台。

• 高效的数据管理:利用Docker的版本控制和回滚特性,设计恢复出厂设置并清空用户数据的功能,并为以后Android镜像更新时能够快速部署,及时把新版本推送做准备。

• 较高系统安全性:把安卓放在密封的容器当中,其外部访问数据都通过QEMU pipe交给上层Anbox前端应用接管,其应用也只有基本的输入输出功能,安全性较高。

• 极低的运行损耗:通过容器直接基于现有系统Linux内核运行,并基于Linux内核特性进行容器隔离,这一方案提高了稳定性并降低了运行损耗。

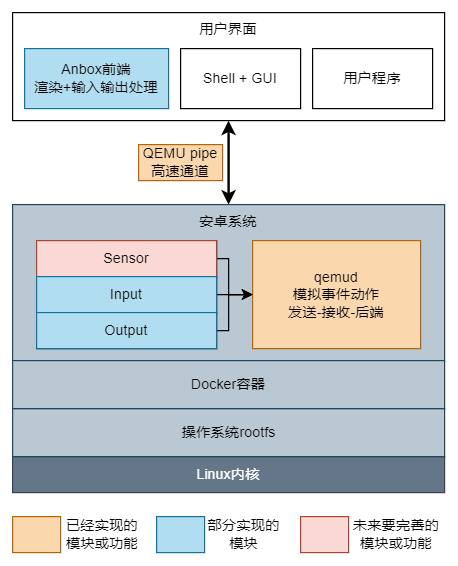

(2). 中间层:安卓中运行qemud提供QEMU pipe这一高速管道与上层通信:

• 成熟的通信方案:这一通信方案基于成熟的Anbox的通信这一部分的功能实现,其上层Session Manager提供接口,由安卓和Anbox两端利用相应API把接口打开进行通信。其实现方案最早可以追溯到2013年的谷歌Goldfish的Android模拟器实现并且沿用至今,实现了Android与Linux的之间通信的兼容性与健壮性并存的实现方式。

• 便捷的交互方式:本方案在安卓与Linux之间的通信方案设计基于QEMU pipe这一高速通道,直接在Android与Linux之间打通一个灵活的通信渠道。本方案不用考虑需要的具体通信实现,直接在安卓HAL层服务和上层Anbox前端应用中打开相应通道进行安卓与Linux对接的数据通信。

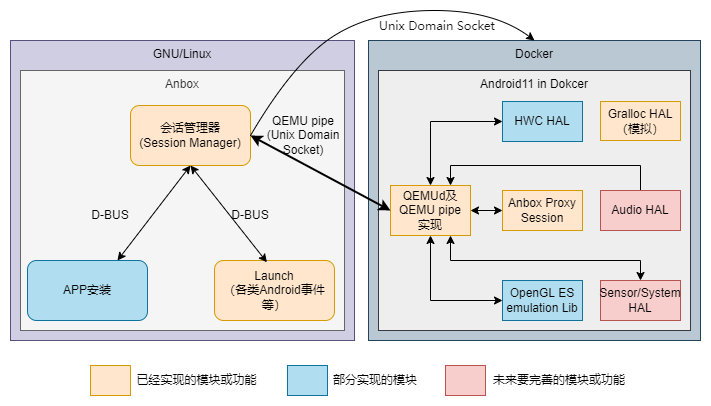

(3). 上层部分:Anbox通过QEMU pipe与底层通信,接收安卓的渲染信息渲染以及音频在上层APP输出,把上层前端APP的输入和状态传递给安卓。

• 兼容性高:主要体现在Linux下对Anbox的兼容性,这一方案的设计把安卓需要与Linux交互和获取的数据都通过QEMU pipe传输给Linux处理,上层Anbox前端不依赖硬件。尤其是渲染也是调用系统现有OpenGL库实现,兼容性相比虚拟机来说更高。

• 易用性高:通过上层Anbox应用接管底层安卓的输入输出等部分,相当于把安卓应用直接映射给了Linux应用。这一操作安卓应用非常接近使用Linux应用的方式,极大的提高了其易用性,操作起来也更加简单。

1.2 开发计划与进展

1.2.1 开发计划

(1) 开发计划表

| 时间节点 | 内容 |

|---|---|

| 5月1日-5月31日 | 完成安卓11运行在Docker上的核心Demo |

| 6月1日-6月15日 | 移植Anbox各个组件到安卓11,初步先移植Anbox的OpenGL和输入部分 |

| 6月16日-6月30日 | 完成Anbox的通信组件移植 |

| 7月1日-7月31日 | 完成剩余Anbox组件移植并测试 |

| 8月1日-8月15日 | 完成最终项目提交、整理项目、准备答辩内容 |

1.2.2 比赛过程中的重要进展

(1) 比赛进展表

| 时间节点 | 负责人 | 完成工作 | 里程碑 |

|---|---|---|---|

| 3月7日-3月22日 | 田梓汎 | Android 11内核在docker上运行的实现 | |

| 3月23日-4月5日 | 张阳彬 | Android 11组件的改造和规范 | |

| 4月6日-5月4日 | 邹明燊 | 完成Android工程文件编写和ASOP编译 | |

| 5月5日-5月14日 | 田梓汎、张阳彬 | 完成Android基础核心功能测试 | |

| 5月15日-5月20日 | 邹明燊 | 完成Android基础核心功能的运行演示 | 核心对Docker适配成功完成于5月20日 |

| 5月21日-6月5日 | 全体队员 | 完成项目文档编写和整理 | |

| 6月20日-7月10日 | 邹明燊、张阳彬 | 完成Anbox中间层的通信组件移植 | 通信组件成功完成于7月10日并通过基础测试 |

| 7月1日-7月15日 | 张阳彬、田梓汎 | 完成对Anbox的图形及渲染部分的分析文档 | |

| 7月10日-7月25日 | 邹明燊 | 完成Anbox中上层各组件移植 | |

| 7月25日-8月2日 | 邹明燊 | 完成OpenGL部分渲染的初步RPC调用测试 | 渲染组件成功完成于8月2日 |

| 8月2月-8月15日 | 全体成员 | 完成项目文档编写和整理 |

1.2.3 项目测试

测试思路主要分为三步:第一步检测Bitcomet能否成功启动容器内的Android系统,主要检测其Android系统开启是否正常,是否成功进入系统界面。如果第一步成功,则基础系统运行测试正常,可以保证Bitcomet内Android系统的基本运作,遂进入第二步测试。第二步测试主要针对Bitcomet容器内的Android系统主要功能是否正常,这一步的检测将包括三个部分分别针对Android系统的三大主要功能进行测试,其中包括有系统信息测试,基础功能测试以及基础应用测试。通过第二部测试的目的是检测Bitcomet内启动成功后Android系统的整体功能完善性。最后是第三步的测试。上两部分的测试主要是检测系统的基本运行以及功能,这一部分测试主要检测在Bitcomet中运行Android的效率,会通过统一变量同时对比Bitcomet与市面上成熟的Android模拟器的性能差距,从而展现Bitcomet方案不可忽视的优势。

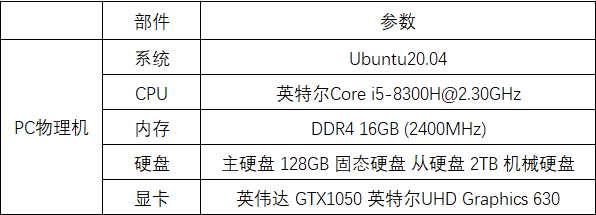

测试环境

本次测试环境硬件参数将统一为下表状态

| 部件 | 参数 |

|---|---|

| 系统 | Ubuntu20.04 |

| CPU | 英特尔 i5-8300H@2.3Ghz |

| 内存 | DDR4 16GB (2400MHz) |

| 硬盘 | 主硬盘 128G SSD 从硬盘 2TB HDD |

| 显卡 | 英伟达 GTX1050&英特尔UHD Graphics 630 |

(1) 基础系统运行测试简介以及结果

这一步主要通过安装环境→加载内核和挂载文件系统→启动Bitcomet并连接容器内的Android来查看其运行情况。

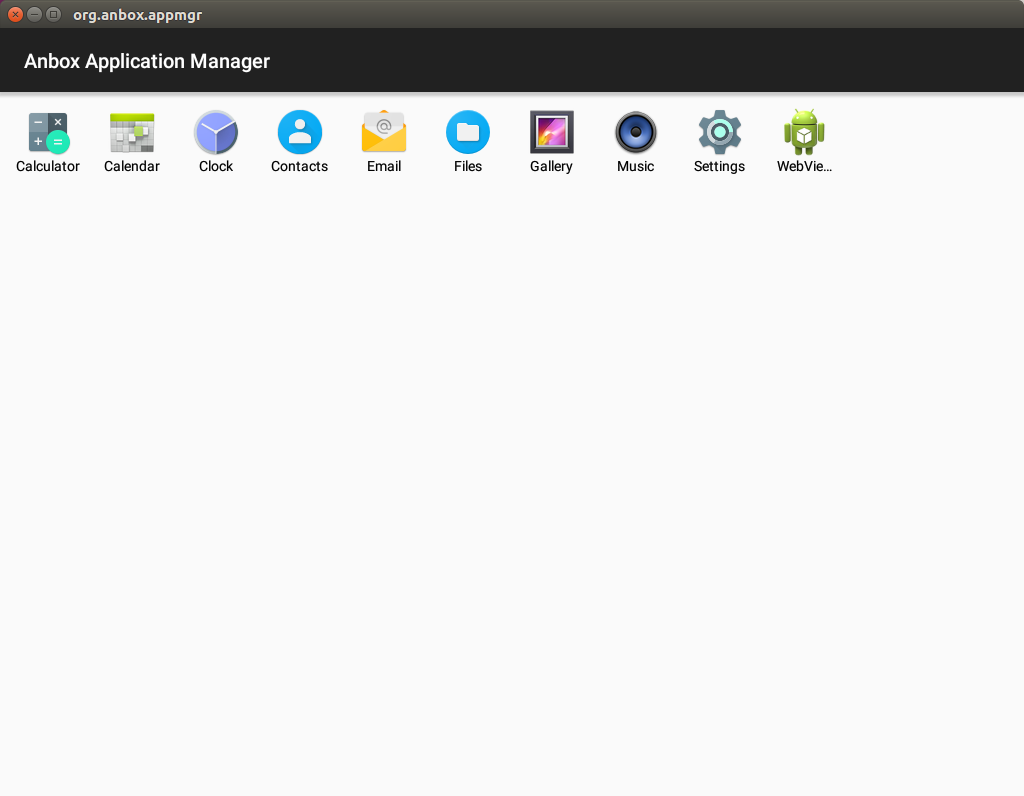

在根据测试步骤,下载测试镜像,安装环境并加载启动Bitcomet所需模块后,Bitcomet可成功启动,通过相关命令可以进入Android shell模式,QtScrcpy投屏软件可以连接Bitcomet并显示Android界面。系统成功启动,运行正常。

(2) 系统功能测试简介以及结果

这一步测试分为三个部分进行,以下为各个部分的测试简介:

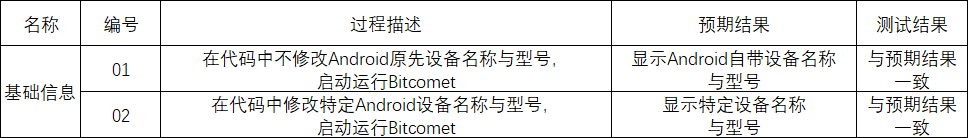

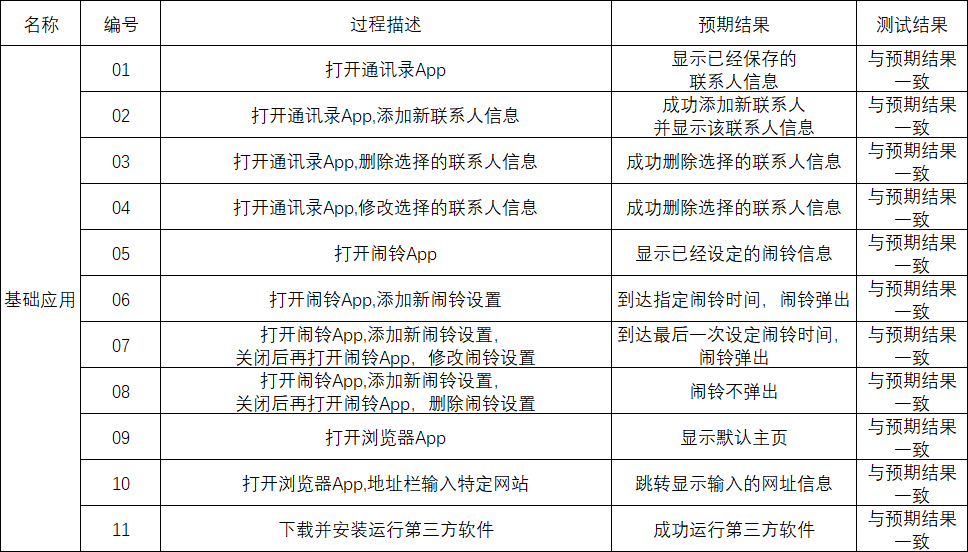

① 系统信息测试,主要测试系统设备名。

② 基础功能测试,主要测试各基础主要功能例如默认语言,WIFI等。

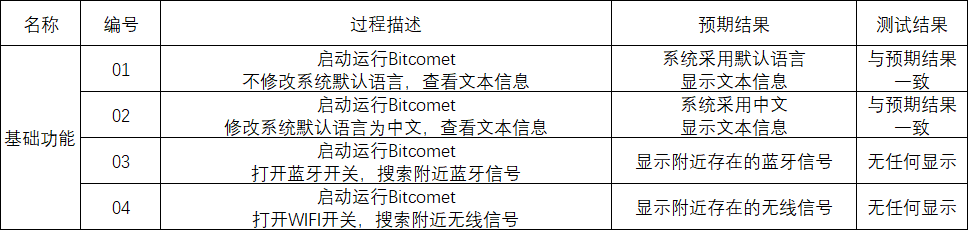

③ 基础应用测试,主要测试系统默认应用运行情况以及第三方应用运行情况。

测试结果主要如下:

| 成功 | 失败 |

|---|---|

| 系统信息和基础功能 | 输入(远程) |

| 通讯录、闹铃、浏览器等基础应用以及第三方应用 | 音频 |

| 图形渲染(GPU软件渲染) | 蓝牙WIFI |

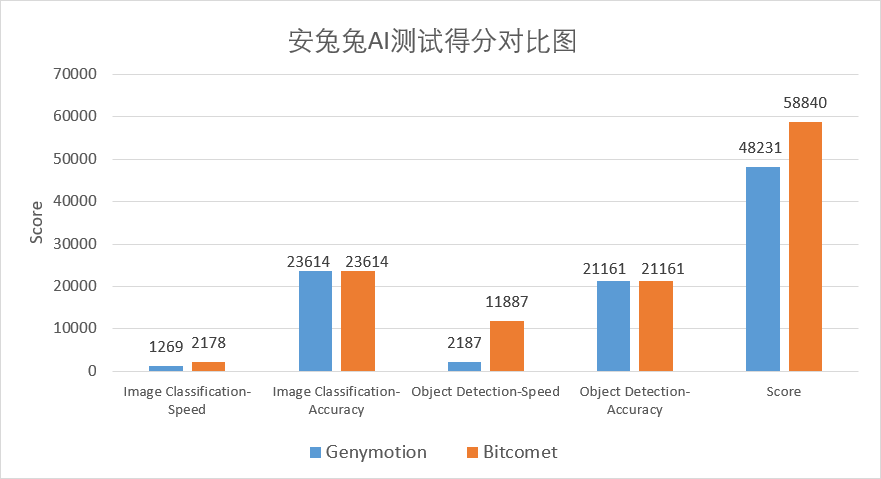

(3) 性能对比测试简介以及结果

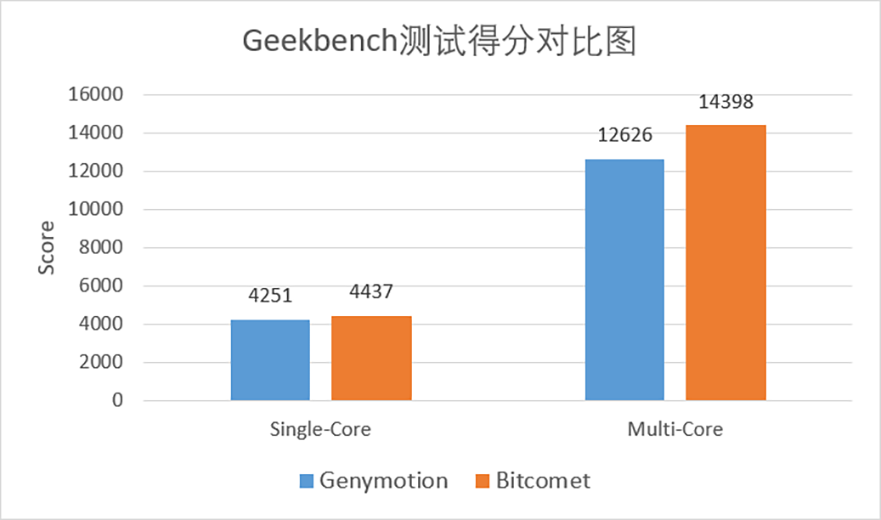

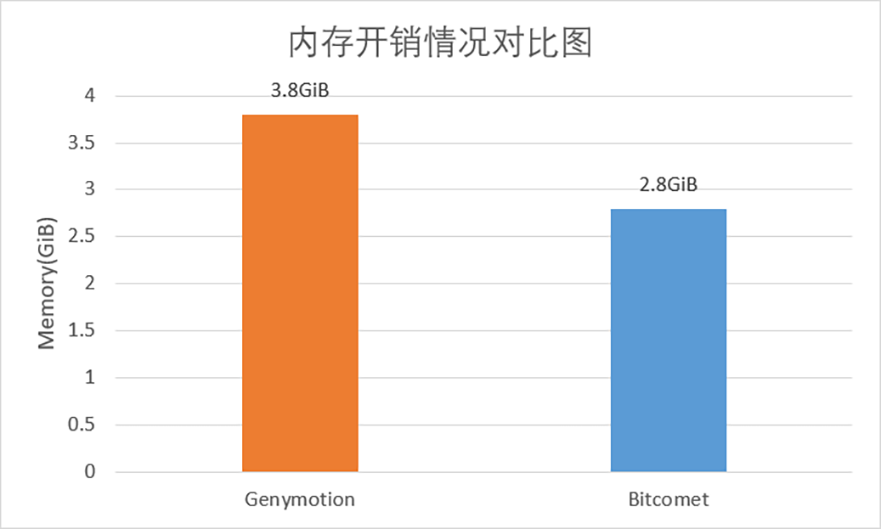

性能对比测试环节:采用Genymotion模拟器来作为对比对象,同时会进行CPU性能对比测试以及内存开销对比测试。CPU性能测试主要使用Android平台主流的基础测试应用Geekbench以及安兔兔AI。Geekbench主要针对于CPU的浮点运算和整数运算部分给出性能量化指标,而安兔兔AI则主要针对CPU中的AI运算部分给出性能量化指标。内存开销测试我们选择各方案仅运行一个Android系统,查看整体内存占用,测出内存开销。

CPU测试部分:在Geekbench测试中,Bitcomet成绩为单核4437分,多核14398分,Genymotion模拟器对照组单核4251分,多核12626分。相比于Genymotion模拟器,Bitcomet单核领先约4.3%,多核领先约14%。性能提升相当于当今移动端旗舰级芯片高通骁龙865和高通骁龙888的性能差距(性能对比数据来自www.socpk.com) ,也就是芯片厂商用一年时间更迭优化出的性能。而在安兔兔AI测试中,Genymotion模拟器得分为48231,Bitcomet得分为58840,Bitcomet更是取得了约22%的显著优势。

内存测试部分:分别测试仅打开Genymotion启动Android系统和仅打开Bitcomet启动Android系统,不运行任何其他应用程序,记录其内存的开销情况,Genymotion模拟器占用整个系统约3.8GiB的内存空间,而Bitcomet占用仅为2.8GiB。占用内存大小仅为Genymotion模拟器的3/4。

(4) 总结

在系统运行测试,系统功能测试部分,Bitcomet已成功在Ubuntu20.04下运行。除部分功能未完善外,通讯录,闹铃,浏览器等基础应用及系统基础信息均可正常使用与显示,也可根据需求安装第三方软件。

通过Bitcomet与Genymotion在CPU性能测试与内存开销测试的情况对比可知,Bitcomet无论是在CPU利用效率还是内存开销上都优于Genymotion。在虚拟化技术成熟的今天,14%性能提升意味着每一百台计算机平台可以少买12台计算机。每百万可以省下12万,又或是在能耗方面做出改进,我们可以限制机器的运行功耗,降至模拟器同样的性能,但是省下更多的电。与此同时,Bitcomet还只是一个“半成品”,其潜力之大可想而知。

演示视频链接: https://pan.baidu.com/s/1FLokWbiU3WNq_i5bhbj7sA?pwd=ew23 提取码: ew23

1.3 项目总结与目录说明

1.3.1 分工和协作

| 项目 | 负责 |

|---|---|

| Docker运行Android 11基础核心的实现 | 田梓汎和张阳彬 |

| Androidlunch工程和项目管理 | 邹明燊 |

| Android基础核心功能测试 | 田梓汎 |

| Andox基础组件移植 | 邹明燊 |

| 图形渲染输入输出测试 | 张阳彬 |

1.3.2 提交仓库目录和文件描述

| 仓库 | 说明 |

|---|---|

| Proj156-bitcomet | 安卓manifests存放位置,项目说明 |

| Proj156_device_bitcomet | 安卓lunch工程,源码device/bitcomet目录 |

| Proj156_frameworks_native | 修改的android/frameworks/native目录 |

| Proj156_frameworks_base | 修改的android/frameworks/base目录 |

| Proj156_system_bpf | 修改的android/system/bpf目录 |

| Proj156_external_selinux | 修改的android/external/selinux目录 |

| Proj156_system_netd | 修改的android/system/netd目录 |

| Proj156_system_libhwbinder | 修改的android/system/libhwbinder目录 |

| Proj156_system_core | 修改的android/system/core目录 |

| Proj156_vendor_bitcomet | 增加的android/vendor/bitcomet目录放一些工程额外加入的包 |

| Proj156_hardware_interfaces | 修改的android/hardware/interfaces目录 |

| Proj156_hardware_libhardware | 修改的android/hardware/libhardware目录 |

| Proj156_system_linkerconfig | 修改的android/system/linkerconfig目录 |

| Proj156_vendor_anbox | 修改的android/vendor/anbox目录 |

注:由于安卓项目太多,所有项目需要通过repo工具组织管理起来,不需要单独拉取覆盖。

2. Bitcomet设计开发文档

简介

Bitcomet是一个基于原有Anbox向Android 11移植实现一种基于Linux系统运行Android 11的解决方案,以下均称呼为Bitcomet。其主要与原有Anbox的改进点在于Android所运行的环境由LXC实现变为更加主流的Docker实现,原有在Anbox不再更新的Android 7更新为Android 11。此外,为了让Android 11能在Docker中运行,本项目针对其SDcard的文件系统挂载机制、SELinux安全机制等进行了相应的移植与优化。为了让Android能在Linux上满足正常使用以及调用GPU进行渲染的需求,本项目参考并移植原有Anbox以及Google安卓模拟器中的相关实现,在移植并搭建起Anbox的跨系统环境通信基础上,使相应的Android各类接口打通到外部Linux,其中最基础的包括图形渲染、图形输出、键鼠输入这三个部分的接口。

本项目主要还是基于Anbox来参考实现,旨在完成以下四个目标:

- 目标1:完成Android11的SDcard的文件系统挂载机制、SELinux安全机制、非特权模式下运行处理对应在Docker容器环境内的处理。

- 目标2:配置安卓项目工程,实现并配置好各个需要的系统模块和AIDL、HIDL、HAL模块,搭建初步调试与测试的Demo1版本,使用adb配合Scrcpy对内部Android远程访问以方便有个初步预期,并且方便本项目有个初步测试的环境。

- 目标3:完成Anbox通信部分实现向Android 11的移植,使Android能与Anbox外部实现跨系统环境通信。

- 目标4:完成Anbox安卓其余部分的各个模块移植,使Android的三个基础部分OpenGL、HWC图形输出、键鼠输入能正常工作。

目前,我们的赛题完成度如下:

| 目标编号 | 基本完成情况 | 额外说明 |

|---|---|---|

| 1 | 基本完成(≈85%) | 1. 与SDcard以及SELinux组件相关的Android 11的基本功能、SDcard文件管理、安装第三方软件、闹铃与联系人等基础应用测试均通过。 2. 非特权模式仅做了部分处理,未进行测试。 |

| 2 | 基本完成(≈90%) | 1. 搭建好相关容器,进行相关基础测试并通过。 2. 目前网络部分由于在Docker特权模式下运行,可能会有Bug。 |

| 3 | 初步完成(≈80%) | 1. 完成跨系统环境通信,安卓中Anbox的相关模块可以使用QEMU_PIPE(实际容器中是没有QEMU设备,而是使用了Unix Domain Socket代替,但其通信的相关通道仍然叫做QEMU PIPE)进行通信或者使用Anbox实现的RPC调用。 2. Anbox的OpenGL ES的emulation库实现初步测试能通过该通信创建QEMU_PIPE连接,实现RPC调用获取到主机侧支持的OpenGL信息。 3. 由于各个部分的模块暂未完全移植好,还需要全部移植才能测试所有功能。 |

| 4 | 初步测试(≈60%) | 1. 已经把相应的Anbox的各个模块的移植到Android中,其中GPS与Audio模块使用了谷歌给Goldfish的实现。 2.OpenGL ES实现和HWC实现在Android 11下无法测试,由于Android 11的相关变动,导致输出画面调用了Gralloc的PostFB去输出,而在Anbox中是未做这部分RPC调用的,输出画面失败。 3.把相关方案在Android 10上进行测试,测试可以输出画面,但卡在安卓Launcher第一屏画面。 |

| 总计 | ≈80% | 1. 本项目自立项以来经历了三个月的时间进行研究与开发,实现方案的过程中遇到困难重重,主要遇到的阻力在系统庞大、相关实现的资料缺失方面。 2. 目前还有部分的工作需要测试和完成。由于Android 11在图形和音频方面变动较大,即使目前进行了相关模块的移植,但是还需要在图形模块、音频模块、输入模块方面进行各类测试和调试工作。 3. 项目将放在Github进行公开,把截至目前学习的成果公开,希望后续有更多的参与者参与进来进行开发完善。 |

2.1 Bitcomet方案设计与分析

2.1.1 为什么选择使用容器与Anbox

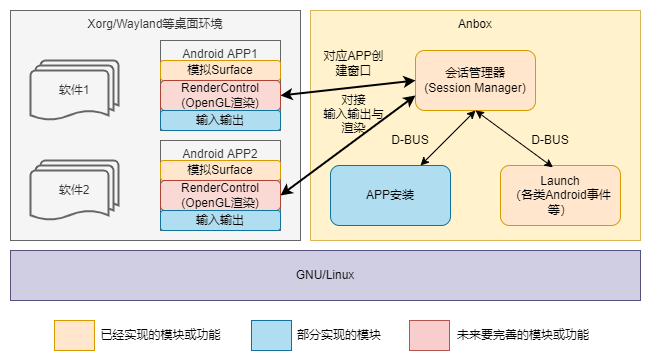

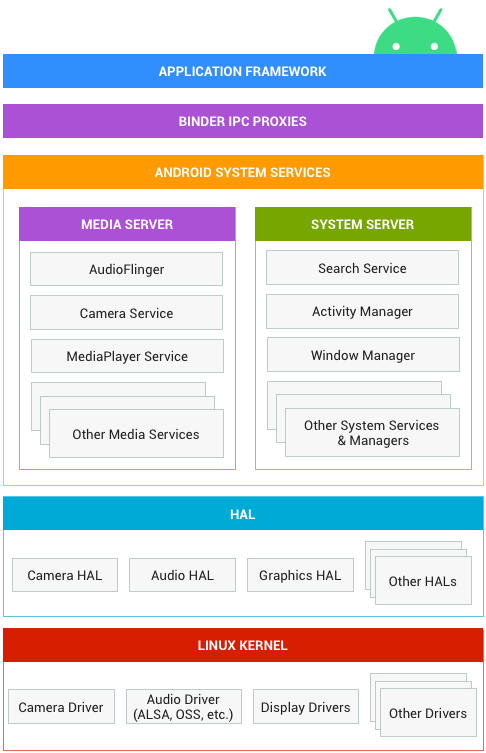

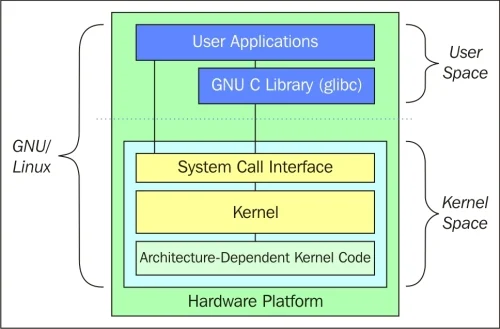

本Bitcomet方案旨在于实现在Linux中运行Android 11的解决方案。在这个方案中会遇到一些问题,如下图2.1是Android系统框架图、图2.2 GNU/Linux系统架构图,这两张图清晰明了地展现了Android与Linux环境的差异:

Android与Linux除了内核相似外是完全不一样的系统环境,尤其体现在系统libc库、应用的运行方式、输入输出设备的管理方式、图像合成方式、OpenGL接口、网络管理组件等方面。这些组件绝大部分将会与Linux冲突,导致Linux运行异常或者Android无法直接运行,同时Android的APP也无法在Linux内直接运行。

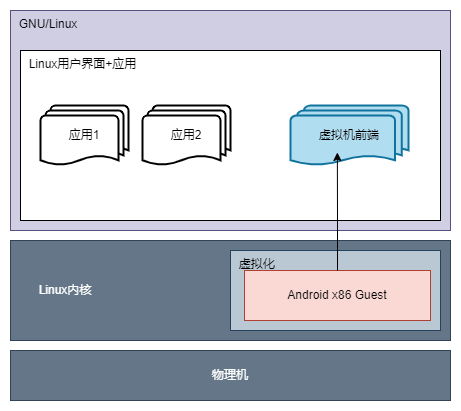

旧方案:在过去面向用户的常见方案中,常用虚拟机来实现这个方案。利用虚拟化功能运行一个Android虚拟机,虚拟机内虚拟或者模拟了电脑绝大部分的硬件,这样既能解决两者接口不同,又能简单实现Android在其他系统上的运行。但是随之而来也有许多缺点:虚拟化需要硬件支持、虚拟化对CPU性能有一小部分损耗、虚拟机本身运行一个全新的系统也需要更多硬件资源、在虚拟机与主机系统间切换也无法很好地利用上常见PC系统的多任务多窗口特性。

相比起虚拟机的实现方法,容器基于Linux内核的命名空间隔离,也能提供一个隔离了Android系统与Linux之间的磁盘、内存等的运行环境。同时容器不需要虚拟化,不需要跑起整个Linux内核,相对应的对硬件资源要求较少,这三个方面看起来有优势。但是容器又出现不一样的问题:相比一般Android模拟器使用的虚拟机,容器又缺少输入输出接口、3D加速与显示输出。

Bitcomet方案:使用容器提供Android运行的环境来实现,其原因如下:该方案可能会在国产化平台上运行,面向不同的硬件环境下不一定支持虚拟化;对硬件资源需求较少;针对容器缺少的输入输出接口以及3D加速与显示输出,谷歌为解决这些问题在安卓模拟器AVD上设计了一套新的方案。另外Anbox在一部分输入输出及3D加速方面正好是复用了谷歌的安卓模拟器的方案,利用了其提供的QEMU_PIPE、emugl、传感器模拟、音频输出等方面提供的实现。

以上是复用了谷歌的实现,但是前端不一样,安卓模拟器的前端是方便谷歌模拟器实现的,而Anbox是需要利用上PC系统的多任务多窗口、方便对接输入输出和控制等的特性。因此Anbox这部分针对谷歌的方案进行了参考重写,把Android中各个不同APP的窗口映射到不同的模拟Surface上。但相应的代价是,由于谷歌3D渲染部分是通过把其指令传输出来交给外部OpenGL渲染,这样性能利用是真机渲染的70%-90%(数据来自参考文献[1]),有一定的损耗。

2.1.2 总结

本项目是这类移植方式中其中一种兼容性较好的方案,其OpenGL ES渲染是通过传输给Anbox并由emugl转换后交给Linux用户空间的OpenGL库实现,OpenGL的对应版本的API是统一的,而Linux平台一般都有GPU驱动+相应库,即使没有也会使用软件OpenGL库,所以这种方案理论上是能适应更多GPU平台的。

总的来说这类移植方式主要都有一类共通点,为了把输入输出、显示渲染等接口打通到对应平台,而不断衍生的技术都有新的优化与改进,尽量减少通信期间数据的拷贝,降低损耗,提高硬件利用率。

2.2 Bitcomet方案设计

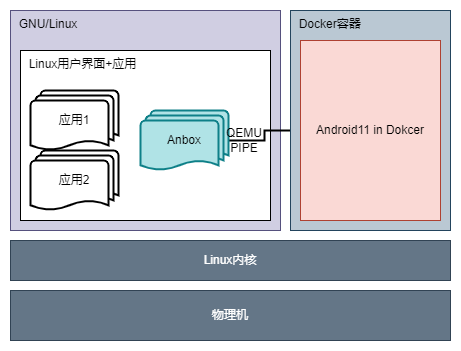

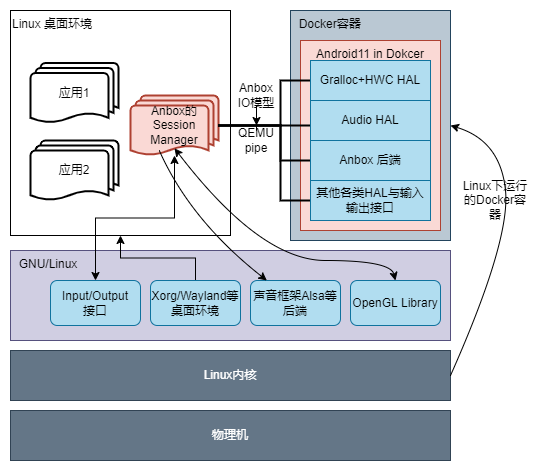

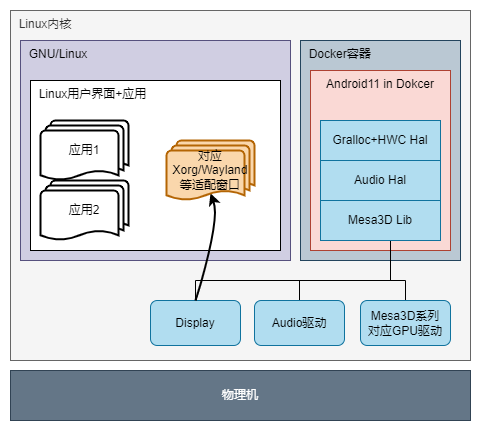

本方案是在Ubuntu 20.04(下图GNU/Linux部分),部署好Docker环境。

Bitcomet底层:其中Android 11的Docker镜像以及Anbox相关组件,均为本方案的实现,经过编译打包并导入Docker的密封环境中。

Bitcomet中间层:在Android 11中,Anbox的后端及相关模块通过桌面下的Anbox前端产生的QEMU pipe进行通信。

Bitcomet上层:Android在容器内缺少图形输出、渲染、音频和键盘设备操作的输入输出功能,其相关功能依赖Anbox的Gralloc、HWC、Audio等相关模块实现。这些模块在QEMU pipe通信的基础上,搭建起对外Linux沟通桥梁,为外部Linux对接内部Android的输入输出、图形输出渲染等功能。外部Anbox针对相关功能实现调用Linux系统库,实现了输入输出渲染等功能。

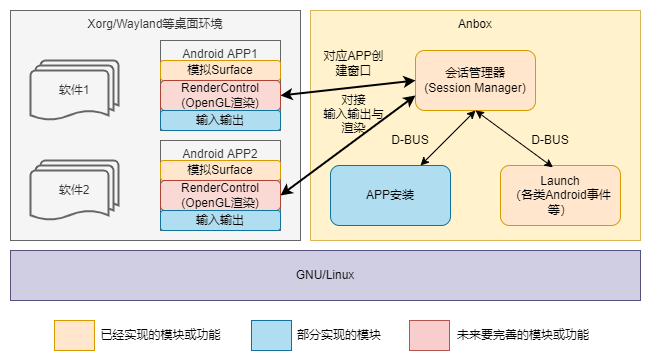

如图2.5是针对Bitcomet各个部分的详细设计:

其中各个部分有相关的实现文档,具体见当前项目下Docs目录内其他文档。

2.2.1 Docker下的安卓11容器设计

(1) 主要工作

在Bitcomet方案底层部分中,使用Docker容器提供Android运行的环境。当然仅仅提供一个环境还不行,Android 11需要依赖Binder、SELinux、SDcardFS、Ashmem等环境的支持。具体的工作如下:

① 内核定制:Binder与Ashmem需要针对内核定制,目前较新的Linux 5.x已经自带BinderFS和Ashmem模块的支持,旧的内核需要使用Anbox提供的Binder或Ashmem模块。

② SELinux安全机制处理:本方案选择了对其相关方法进行屏蔽处理,即使实际测试及Docker文档中都反应了Docker下是可以实现这个支持的,但我们仍然选择了屏蔽,其原因如下:

第一,Docker外是针对指定配置文件的SELinux安全配置,而Android内的还需要单独配置并需要一部分特权。

第二,不同平台的Linux内核不一定提供并使用了SELinux安全模块,遇上没有此模块的平台均无法运行。

第三,使用SELinux后,Docker官方提到可能会对性能有一定的损失。

③ 文件系统挂载处理:SDcardFS部分是安卓8以后提供的模块,可以让Android接管对SDcardFS下的目录文件的访问权限控制。我们选择了使用FUSE来实现挂载SDcard的虚拟文件系统,FUSE是较旧版本的Android采用的一种方式,其实现主要在用户空间,能提供几乎与SDcardFS相同的功能。但FUSE挂载SDcard的实现也有缺点,其速度比SDcardFS的实现慢,我们仍然选择FUSE方案的原因如下:

第一, SDcardFS的实现依赖Linux内核实现,不同Linux内核对其支持不一样。

第二, 由于SDcardFS在内核实现,挂载它也需要一定的特权。

(2) Bitcomet底层部分特点

Docker下的安卓11容器设计:

• 高可移植设计:使用了Docker便集成了Docker相关的优点,Docker相比原有LXC有可移植性、版本控制、回滚、快速部署等优点。同时原有LXC容器与Anbox进行了高度集成,在目前多平台和可移植性考量下,原有Anbox的系统镜像与各个配置选项都不能方便地进行更改,这将会导致我们适配到国产系统中遇到重重困难。

• 快速迭代更新:使用Docker提供底层容器运行环境,利用其快速部署的优点,可以使Android 11更加灵活地运行在目标平台。

• 高效的数据管理:利用Docker的版本控制和回滚特性,设计恢复出厂设置并清空用户数据的功能,并为以后Android镜像更新时能够快速部署,及时把新版本推送。

• 较高系统安全性:把安卓放在密封的容器当中,其外部访问数据都通过QEMU pipe交给上层Anbox前端应用接管,其应用也只有基本的输入输出功能,安全性较高。

• 极低的运行损耗:通过容器直接基于现有系统Linux内核运行,并基于Linux内核特性进行容器隔离,这一方案提高了稳定性并降低了运行损耗。

2.2.2 安卓与上层Anbox通信设计

(1) 主要工作

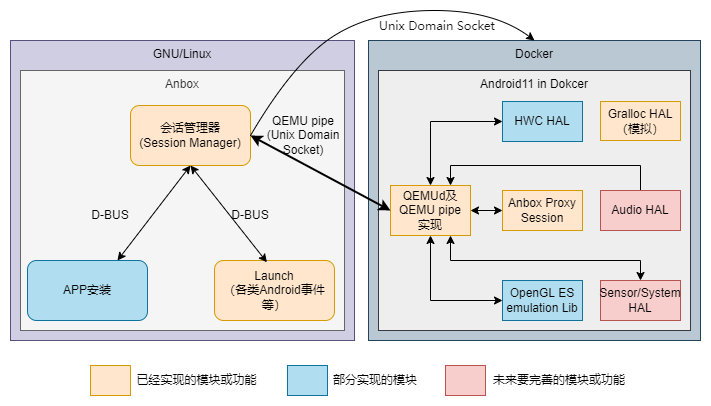

在Bitcomet中间层中,我们复用了Anbox这一实现,把其相关实现移植到Android11,并实现其上面的各种功能。我们的主要工作如下:

① 通信实现:把Anbox基于QEMU pipe和qemud的实现移植到Android11,这两个实现的本质均为通过QEMU pipe实现,但由于容器内没有实质上的QEMU pipe设备,因此Anbox魔改了一下使用Unix Domain Socket实现,这种实现从原理上说与QEMU pipe的区别在于:第一,QEMU pipe设备是通过QEMU的相关模拟实现的,其模拟的设备支持DMA,理论上比Unix Domain Socket这一软件实现更有效率;第二,Anbox这里相关实现的名字还是叫做QEMU pipe,而QEMU pipe本身也有tcp socket相关的实现。

② 设备映射:在Docker中映射外部Anbox的Session Manager创建的Socket监听到容器内的/dev对应设备,以便容器内的QEMUd或者QEMU pipe相关实现进行调用。

③ Anbox通信模块移植:容器内Anbox为这些实现封装成了叫做HOST_CONNECTION的方法,容器外Anbox基于谷歌的ProtoBuf实现一种通信模型,其中包括OpenGL ES、HWC、模拟的Surface、Anbox Proxy等组件的RPC调用,以便内部Anbox通过这些封装的方法直接调用,我们也针对这些方法进行了移植和部分测试。

(2) Bitcomet中间层部分特点

安卓中运行qemud提供QEMU pipe这一高速管道与上层通信:

• 成熟的通信方案:这一通信方案基于成熟的Anbox的通信这一部分的功能实现,其上层Session Manager提供接口,由安卓和Anbox两端利用相应API把接口打开进行通信。其实现方案最早可以追溯到2013年的谷歌Goldfish的Android模拟器实现并且沿用至今,实现了Android与Linux的之间通信的兼容性与健壮性并存的实现方式。

• 便捷的交互方式:本方案在安卓与Linux之间的通信方案设计基于QEMU pipe这一高速通道,直接在Android与Linux之间打通一个灵活的通信渠道。本方案不用考虑需要的具体通信实现,直接在安卓HAL层服务和上层Anbox前端应用中打开相应通道进行安卓与Linux对接的数据通信。

2.2.3 上层Anbox的OpenGL ES渲染以及输入输出设计

(1) 主要工作

在Bitcomet的上层中,我们也复用Anbox的实现,把其相关部分移植到Android11和Ubuntu 20.04上。Android中对接外部Linux主要在图形输出、渲染、输入输出部分缺失,这些部分需要靠Anbox在中间通信层的部分实现之上,建立各个部分的连接,打通到外部Linux上。我们的主要工作如下:

① HAL层模块移植:这一部分主要工作在Android中HAL层的移植以及测试,我们经过在Android工程中对AIDL与HIDL对应HWC与Gralloc部分的模块进行配置,Gralloc的HAL层复用最新Android 11中对安卓模拟器的AVD实现。我们复用Android 11的这一部分主要原因在于其安卓模拟器的实现与Anbox的实现是一样的,都是软件实现的调用ashmem申请图形缓冲区。

② 图形输出部分移植:从Android的HAL层中Gralloc与HWC模块开始,图形输出部分的核心模块是HWC模块,它负责被SurfaceFlinger调用进行图层合成输出到显示设备,而这里我们选择在Anbox的实现上进行移植修复。该实现主要测试点在于图形HWC,HWC中的发送图层部分开始,通过Anbox的RPC调用,发送图层到外部Anbox的Surface上,需要测试相关图层测试数据是否能到达外部Anbox上合成输出。

③ 输入输出部分移植:在输入部分,Anbox的Session Manager注册了多个Event设备以及audio传输设备,我们需要把这些设备在Docher中映射到/dev下,以便在Android中调用。其中音频部分也复用Android11针对模拟器部分的audio HAL实现,原因在于Anbox这些部分的实现也是复用Android模拟器的实现,其原理是把音频PCM数据通过Anbox的RPC调用方法发送到外部Anbox进行解码播放。

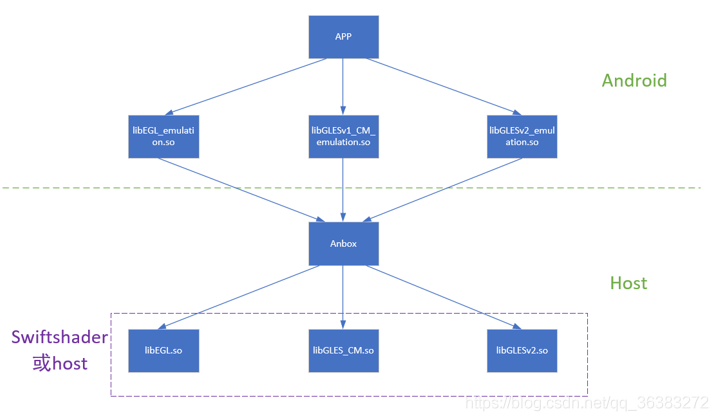

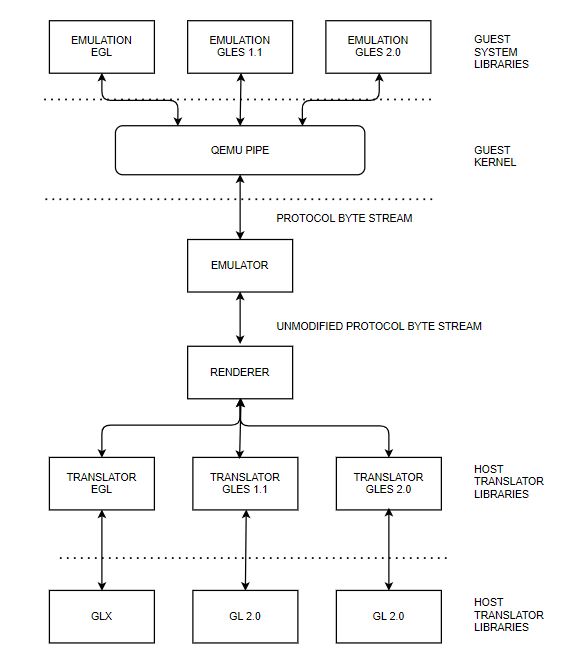

④ OpenGL ES部分移植:Anbox的OpenGL库主要在Android的 /system/lib64/egl 目录下安装了三个动态库,分别为libEGL_emulation.so、libGLESv1_CM_emulation.so和libGLESv2_emulation.so。Anbox在其中提供虚拟的硬件厂商配置,为Android提供OpenGL ES渲染库。但Anbox实际渲染工作并不是上述三个库文件,这三个库文件作用为采集Android中APP渲染的OpenGL ES指令,并通过高速传输通道qemu-pipe传输将指令传至宿主机Anbox进程中,实际渲染工作由宿主机执行。这部分主要也是移植好Anbox这几个库,检验该三个库与上层Anbox的通信,这部分库也是复用谷歌Android的安卓模拟器AVD实现,主要测试工作在于做相关指令的通信以及实际渲染测试。

(2) Bitcomet上层部分特点

Anbox通过QEMU pipe与底层通信,接收安卓的渲染信息渲染以及音频在上层APP输出,把上层前端APP的输入和状态传递给安卓:

• 兼容性高:主要体现在Linux下对Anbox的兼容性,这一方案的设计把安卓需要与Linux交互和获取的数据都通过QEMU pipe传输给Linux处理,上层Anbox前端不依赖硬件。尤其是渲染也是调用系统现有OpenGL库实现,兼容性相比虚拟机来说更高。

• 易用性高:通过上层Anbox应用接管底层安卓的输入输出等部分,相当于把安卓应用直接映射给了Linux应用。这一操作安卓应用非常接近使用Linux应用的方式,极大的提高了其易用性,操作起来也更加简单。

3.1 安卓图形架构中的Anbox的HAL模块

在安卓官方文档当中,安卓的系统架构被分为五层架构,其五层架构分别为

| 架构 | 主要负责的内容 |

|---|---|

| 应用框架 APP FRAME | 应用框架主要为开发者使用,开发者API提供了很多映射至底层的HAL接口,提供实现驱动程序的相关信息 |

| Binder IPC | 主要负责进程间的通讯,不仅仅是顶层进程之间的交互,更重要的是支持顶层进程和安卓系统服务间甚至是HAL的交互 |

| 系统服务 | 安卓把各种各样的系统服务包装为各种模块化组件,可以方便后续升级。其中包括有DNS解析模块,媒体模块等。 |

| 硬件抽象层HAL | HAL可以定义一个接口给硬件供应商实现,主要用于实现系统服务和底层驱动程序的通讯和运作。其被封装成一个模块被安卓系统随时调用 |

| Linux内核 | Android使用的linux内核与一般的内核不同,如:必须支持Binder、包含一些特殊功能(内存守护) |

3.1.1 安卓图形部分架构以及Anbox图形模块

其中在Anbox的图形模块中,最主要关心的就是HAL层以及LINUX KERNEL。因为本项目中安卓是运行在容器内的,安卓不能像原生一样顺利地让HAL层直接调用其LINUX KERNEL内的驱动和所需资源,而是要跟容器外部正在运行的LINUX环境对接。在本项目中的这一目标就是努力让容器内的安卓与容器外本不兼容的LINUX环境对接,成功把图形化渲染的工作交给LINUX环境当中,实现渲染效率比软件模拟成倍提升的效果。

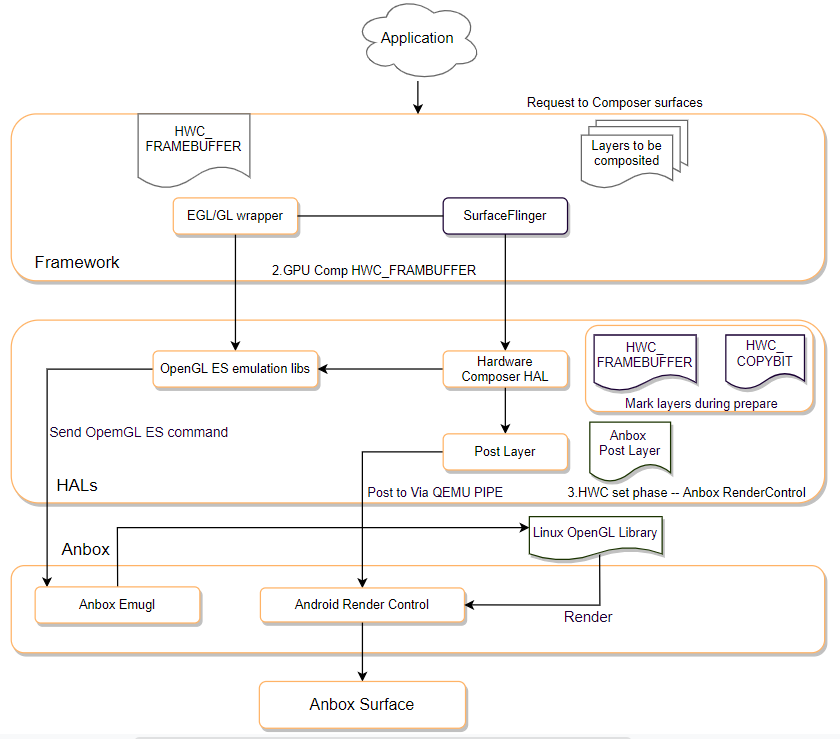

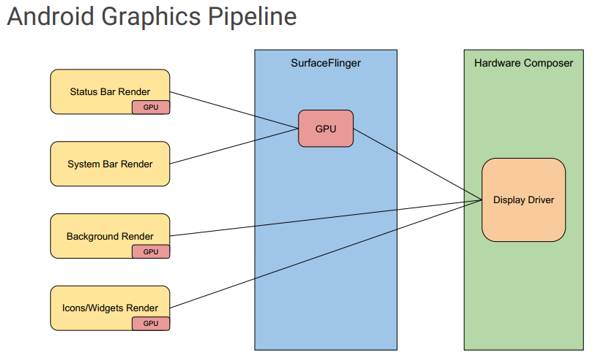

在安卓主要的图形模块当中,所有的渲染信息流大致如图3.1所示。

(1) HAL层

在本文档中,主要聚焦于HAL层anbox的实现。在安卓系统中HAL层包括两个组件,HWC(Hardware Composer)与Gralloc。

HWC(Hardware Composer)模块

① 初步介绍

无论开发者使用什么渲染API,一切的内容都将会渲染到surface上,surface可以被理解为是一个生产缓冲区,整一个被渲染的surface队列都会被surfaceflinger所消耗而准备合成到屏幕上。

合成是一种将缓冲区队列内所有元素有规律有层级的覆盖为一块画面的操作。 在安卓系统中,surface队列内的元素通常是大小不一且杂乱的,因为来自多个不同源的缓冲区,例如有些是出于顶部的状态栏,有些是出于底部的导航栏,而中间的应用内容也是一层缓冲区,直接送出来的画面完全不是屏幕在显示的画面。怎么解决这个问题?在安卓中选择了效率最高的方式来处理合成问题——将三个缓冲区全部传送到显示硬件,并指示它从不同的缓冲区读取屏幕不同部分的数据。这个操作的承担者就是硬件混合渲染器HAL层。

合成到屏幕这一步就需要调用我们的HAL层中的HWC了。HWC主要跟屏幕显示组件通讯,获得屏幕相应的参数,计算出最常用的四个不同的部分——状态栏、系统栏、应用以及壁纸/背景所覆盖的画面,再接受surfaceflinger需要合成的队列所拥有的内容,把这些内容分别合成到状态栏、系统栏、应用以及壁纸/背景所覆盖的画面后再与屏幕沟通,最终显示在真正现实的手机屏幕上。

当然,HWC也会负责虚拟屏幕合成,同时会向硬件设备注册三个回调,以便应对这些事件的发生:屏幕热插拔,刷新和VSync信号。

在Anbox当中,HWC还有一个比较重要的功能,它可以把单个安卓里面的应用程序映射到桌面环境的单个窗口中,因为在桌面环境下我们不需要再像现实中让HWC把所有内容合成到一块屏幕上。Anbox会通过其hwcomposer实现告诉SurfaceFlinger为每个应用程序获取一个层,并将其与从Android WindowManager收到的额外信息结合起来,将单个层映射到应用程序。

② HWC模块重要实现

安卓中HWC部分的实现

首先surfaceflinger创建HWComposer。

//节选自main_surfaceflinger.cpp

void SurfaceFlinger::init() {

// Initialize the H/W composer object. There may or may not be an

// actual hardware composer underneath.

mHwc = new HWComposer(this,

*static_cast<HWComposer::EventHandler *>(this));//调用构造函数

}

HWComposer构造函数。

//节选自DisplayHardware/HWComposer.cpp

HWComposer::HWComposer(const sp<SurfaceFlinger>& flinger)

: mFlinger(flinger),

mAdapter(),

mHwcDevice(),

mDisplayData(2),

mFreeDisplaySlots(),

mHwcDisplaySlots(),

mCBContext(),

mEventHandler(nullptr),

mVSyncCounts(),

mRemainingHwcVirtualDisplays(0)

{

for (size_t i=0 ; i<HWC_NUM_PHYSICAL_DISPLAY_TYPES ; i++) {

mLastHwVSync[i] = 0;

mVSyncCounts[i] = 0;

}

loadHwcModule(); //调用HWC模块

}

HWComposer构造函数一般使用loadHwcModule方法加载来HWComposer模块。

//节选自DisplayHardware/HWComposer.cpp

void HWComposer::loadHwcModule()

{

ALOGV("loadHwcModule");

// 其定义在hardware.h中,表示一个硬件模块

hw_module_t const* module;

// 加载硬件厂商提供的hwcomposer模块,HWC_HARDWARE_MODULE_ID定义在hwcomposer_defs.h中,表示"hwcomposer"

if (hw_get_module(HWC_HARDWARE_MODULE_ID, &module) != 0) {

ALOGE("%s module not found, aborting", HWC_HARDWARE_MODULE_ID);

abort();

}

hw_device_t* device = nullptr;

// 通过硬件厂商提供的open函数打开一个"composer"硬件设备,HWC_HARDWARE_COMPOSER也定义在hwcomposer_defs.h中,表示"composer"

int error = module->methods->open(module, HWC_HARDWARE_COMPOSER, &device);

if (error != 0) {

ALOGE("Failed to open HWC device (%s), aborting", strerror(-error));

abort();

}

uint32_t majorVersion = (device->version >> 24) & 0xF;

// mHwcDevice是HWC2.h中定义的HWC2::Device,所有与HWC的交互都通过mHwcDevice

if (majorVersion == 2) { // HWC2,hwc2_device_t是hwcomposer2.h中的结构体

mHwcDevice = std::make_unique<HWC2::Device>(

reinterpret_cast<hwc2_device_t*>(device));

} else { // 设备是基于HWC1,这里用HWC2去适配,Android7.0及以前默认都是HWC1,hwc_composer_device_1_t是hwcomposer.h中的结构体

mAdapter = std::make_unique<HWC2On1Adapter>(

reinterpret_cast<hwc_composer_device_1_t*>(device));

uint8_t minorVersion = mAdapter->getHwc1MinorVersion();

if (minorVersion < 1) {

ALOGE("Cannot adapt to HWC version %d.%d",

static_cast<int32_t>((minorVersion >> 8) & 0xF),

static_cast<int32_t>(minorVersion & 0xF));

abort();

}

mHwcDevice = std::make_unique<HWC2::Device>(

static_cast<hwc2_device_t*>(mAdapter.get()));

}

// 获取硬件支持的最大虚拟屏幕数量,VirtualDisplay主要是用来用于录屏

mRemainingHwcVirtualDisplays = mHwcDevice->getMaxVirtualDisplayCount();

}

先加载hwcomposer模块得到hw_module_t,再打开composer设备得到hw_device_t。所以一般情况下是先有HAL模块,再有实现此模块的硬件设备。

//节选自hardware/libhardware/include/hardware/hardware.h

typedef struct hw_module_t {

//每一个HAL库都会提供的一个方法methods,

struct hw_module_methods_t* methods;

}hw_module_t;

typedef struct hw_module_methods_t {

//这个 methods的数据结构中只有一个函数指针变量open,用来打开指定的硬件设备。

int (*open)(const struct hw_module_t* module, const char* id,

struct hw_device_t** device);

} hw_module_methods_t;

在每个HAL层模块实现都要定义一个HAL_MODULE_INFO_SYM数据结构,并且该结构的第一个字段必须是hw_module_t,下面是anbox当中hwcomposer模块的定义。

//节选自vendor/anbox/android/hwcomposer/hwcomposer.cpp

hwc_module_t HAL_MODULE_INFO_SYM = {

.common = {

.tag = HARDWARE_MODULE_TAG,

.version_major = 1,

.version_minor = 0,

.id = HWC_HARDWARE_MODULE_ID,

.name = "Hardware Composer Module",

.author = "Anbox Developers",

.methods = &hwc_module_methods,

}

};

这里Anbox中对应method如下,实现了打开模块的接口。

//节选自vendor/anbox/android/hwcomposer/hwcomposer.cpp

//methods数据结构中只有一个函数指针变量open,用来打开指定的硬件设备(Anbox中是软件实现)

static hw_module_methods_t hwc_module_methods = {

.open = hwc_device_open

};

//Anbox中这里注册了自己实现的HWC设备的各种接口对接函数

static int hwc_device_open(const hw_module_t* module, const char* name, hw_device_t** device) {

ALOGD("%s", __PRETTY_FUNCTION__);

auto dev = new HwcContext;

dev->device.common.tag = HARDWARE_DEVICE_TAG; // 标记这是一个硬件设备的模块

dev->device.common.version = HWC_DEVICE_API_VERSION_1_1; // HWC版本,Anbox还是用的HWC1

dev->device.common.module = const_cast<hw_module_t*>(module); // 对应上面模块信息结构体定义

dev->device.common.close = hwc_device_close; // HWC设备关闭调用的操作

dev->device.prepare = hwc_prepare; // 图层的配置,surfaceflinger把要显示的layers放在displays参数里,针对其参数对应Display硬件配置图层的参数类型等。

dev->device.set = hwc_set; // hwc_set方法,在SurfaceFlinger要求HWC发送图层数据,该方法进行发送相关图层数据给Anbox在Linux的前端实现。

dev->device.eventControl = hwc_event_control; // 使能/禁止vsync,Anbox未实现

dev->device.blank = hwc_blank; // 老的hwc(1.3以前)用blank控制display on/off,最新的hwc里用setPowerMode。实现的功能差不多,但setPowerMode的参数更丰富,不像blank就0/1。

dev->device.query = hwc_query;

dev->device.getDisplayConfigs = hwc_get_display_configs; //获取显示硬件的配置,一般是多显示屏等配置的获取返回,Anbox只有一个主显示器,因此这里只是配置0让HWC进入获取属性的调用。

dev->device.getDisplayAttributes = hwc_get_display_attributes;//获取显示硬件的各个属性

dev->device.registerProcs = hwc_register_procs;

dev->device.dump = nullptr;

*device = &dev->device.common;

return 0;

}

可以看出这一阶段已经完成了Anbox的HWC具体实现的模块打开并注册接口,下面将针对hwc_get_display_attributes和hwc_set进行讲解,这两个是Anbox在HWC这一部分显示输出的精髓。

Anbox部分重要实现

在Anbox的HWC模块中,其中最主要的就是hwc_get_display_attributes和hwc_set的实现,这里把一些重要的部分进行讲解。

hwc_get_display_attributes函数部分实现

//节选自vendor/anbox/android/hwcomposer/hwcomposer.cpp

static int hwc_get_display_attributes(hwc_composer_device_1* dev,

int disp, uint32_t config,

const uint32_t* attributes,

int32_t* values) {

if (disp != 0 || config != 0) {

return -EINVAL;

}

//建立与Anbox前端的QEMU_PIPE连接

DEFINE_AND_VALIDATE_HOST_CONNECTION();

// 下面各个属性都是通过与Anbox连接获取返回的值

while (*attributes != HWC_DISPLAY_NO_ATTRIBUTE) {

//针对各种属性返回对应的值,其中HWC_DISPLAY_NO_ATTRIBUTE是这个attributes数组的结束

switch (*attributes) {

//获取屏幕VSYNC垂直同步信号的周期值

case HWC_DISPLAY_VSYNC_PERIOD:

*values = rcEnc->rcGetDisplayVsyncPeriod(rcEnc, disp);

break;

//获取屏幕宽高和DPI参数

case HWC_DISPLAY_WIDTH:

*values = rcEnc->rcGetDisplayWidth(rcEnc, disp);

break;

case HWC_DISPLAY_HEIGHT:

*values = rcEnc->rcGetDisplayHeight(rcEnc, disp);

break;

case HWC_DISPLAY_DPI_X:

*values = 1000 * rcEnc->rcGetDisplayDpiX(rcEnc, disp);

break;

case HWC_DISPLAY_DPI_Y:

*values = 1000 * rcEnc->rcGetDisplayDpiY(rcEnc, disp);

break;

default:

ALOGE("Unknown attribute value 0x%02x", *attributes);

}

++attributes;

++values;

}

return 0;

}

可以看得出hwc_get_display_attributes是通过Anbox获取屏幕的参数返回给安卓HWC模块,方便给SurfaceFlinger和HWC进行屏幕输出。

接下来查看其中rcEnc调用的方法的来源:

//节选自vendor/anbox/android/hwcomposer/hwcomposer.cpp

//其来自于建立QEMU_PIPE的地方

#define DEFINE_AND_VALIDATE_HOST_CONNECTION() \

//获取Anbox的QEMU_PIPE连接,这部分不再赘述

HostConnection *hostCon = HostConnection::get(); \

if (!hostCon) { \

ALOGE("hwcomposer.anbox: Failed to get host connection\n"); \

return -EIO; \

} \

//获取Host端的rcEncoder方法返回的远程调用对象

renderControl_encoder_context_t *rcEnc = hostCon->rcEncoder(); \

if (!rcEnc) { \

ALOGE("hwcomposer.anbox: Failed to get renderControl encoder context\n"); \

return -EIO; \

}

其来自于建立QEMU_PIPE的地方,通过与外部Anbox建立连接,利用Anbox 基于 Protobuf 设计的 RPC 进行通信,实现远程方法调用。

这里以rcEnc->rcGetDisplayWidth(rcEnc, disp)为例,远程能调用到Anbox在Host端的GL库函数返回的值:

//节选自vendor/anbox/src/anbox/graphics/emugl/RenderControl.cpp

int rcGetDisplayWidth(uint32_t display_id) {

(void)display_id;

// 调用到实际的GL库的函数,获取实际的垂直分辨率大小

return static_cast<int>(anbox::graphics::emugl::DisplayInfo::get()->vertical_resolution());

}

最终能正确通信获得rcGetDisplayWidth返回值。

以上的获取DisplayWidth的实现,其流程从自下向上来看,其流程如下:

首先,hwc_get_display_attributes中的rcEnc->rcGetDisplayWidth远程调用获得了Host端Anbox的窗口垂直分辨率的值。

再者,dev->device.getDisplayAttributes = hwc_get_display_attributes是该HWC注册的方法,被populateConfigs函数调用该模块获取信息。

最后被HWC2On1Adapter::populatePrimary()、HWC2On1Adapter::hwc1Hotplug、HWC2On1Adapter::createVirtualDisplay等方法调用,主要用于在显示设备创建、热插拔时获取显示设备信息返回给SurfaceFlinger及HWC。

hwc_set函数部分实现

dev->device.set是SurfaceFliner要求HWC发送图层数据,在这里Anbox对应注册的函数是hwc_set,其函数实现如下:

//节选自vendor/anbox/android/hwcomposer/hwcomposer.cpp

static int hwc_set(hwc_composer_device_1_t* dev, size_t numDisplays,

hwc_display_contents_1_t** displays) {

// HWC上下文

auto context = reinterpret_cast<HwcContext*>(dev);

if (displays == NULL || displays[0] == NULL)

return -EFAULT;

//通过QEMU_PIPE与Anbox连接,原理同上一步hwc_get_display_attributes中的实现

DEFINE_AND_VALIDATE_HOST_CONNECTION();

// 循环处理当前display的所有层

for (size_t i = 0 ; i < displays[0]->numHwLayers ; i++) {

const auto layer = &displays[0]->hwLayers[i];

//如果是指针或者需要跳过而不用刷新的层,跳过

if (layer->flags & HWC_SKIP_LAYER ||

layer->flags & HWC_IS_CURSOR_LAYER)

continue;

// Anbox下,HWC注册的compositionType是HWC_FRAMEBUFFER_TARGET

if(layer->compositionType == HWC_FRAMEBUFFER_TARGET) {

// 通过getprop去读取“anbox.layer_name”这一系统配置,获取当前要传输的Layer名称

std::string layer_name_temp = android::base::GetProperty("anbox.layer_name", "");

std::string layer_name = layer_name_temp.substr(0, layer_name_temp.find('#'));

strncpy(layer->name, layer_name.c_str(), layer_name.size());

}

// 根据图层的三组必要参数,发送Layer

rcEnc->rcPostLayer(rcEnc,

layer->name,

cb->hostHandle,

layer->planeAlpha / 255,

layer->sourceCrop.left,

layer->sourceCrop.top,

layer->sourceCrop.right,

layer->sourceCrop.bottom,

layer->displayFrame.left,

layer->displayFrame.top,

layer->displayFrame.right,

layer->displayFrame.bottom);

hostCon->flush(); //刷新缓冲区

}

// 通知Anbox所有发送完毕

rcEnc->rcPostAllLayersDone(rcEnc);

check_sync_fds(numDisplays, displays);

return 0;

}

该函数中,第一个系统配置“anbox.layer_name”是Anbox修改了SurfaceFlinger,在准备输出图层前把图层名称保存成这个配置中,具体实现如下:

//节选自:frameworks/native/services/surfaceflinger/BufferLayer.cpp

//SurfaceFlinger

void BufferLayer::setPerFrameData(const sp<const DisplayDevice>& displayDevice,

const ui::Transform& transform, const Rect& viewport,

int32_t supportedPerFrameMetadata,

const ui::Dataspace targetDataspace) {

RETURN_IF_NO_HWC_LAYER(displayDevice);

// Apply this display's projection's viewport to the visible region

// before giving it to the HWC HAL.

//获取可见区域

Region visible = transform.transform(visibleRegion.intersect(viewport));

// 寻找当前显示器的输出图层

const auto outputLayer = findOutputLayerForDisplay(displayDevice);

LOG_FATAL_IF(!outputLayer || !outputLayer->getState().hwc);

//获取HWC

auto& hwcLayer = (*outputLayer->getState().hwc).hwcLayer;

//保存当前图层名称到anbox.layer_name系统配置中

android::base::SetProperty("anbox.layer_name", mName.string());

//设置刚刚获取的可见区域到HWC

auto error = hwcLayer->setVisibleRegion(visible);

if (error != HWC2::Error::None) {

ALOGE("[%s] Failed to set visible region: %s (%d)", mName.string(),

to_string(error).c_str(), static_cast<int32_t>(error));c

visible.dump(LOG_TAG);

}

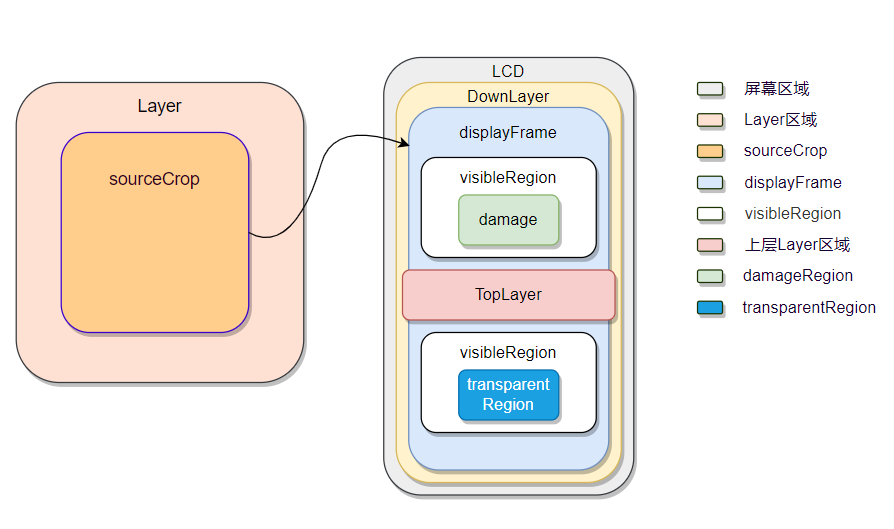

而rcEnc->rcPostLayer中planeAlpha、sourceCrop、displayFrame就是下图中各个区域,如图3.5所示。

第一,sourceCrop是对Layer进行剪切的,值截取部分Layer的内容进行显示;sourceCrop不超过Layer的大小,超过没有意义。

第二,displayFrame表示Layer在屏幕上的显示区域,具体说来,是sourceCrop区域在显示屏上的显示区域。displayFrame一般来说,小于屏幕的区域。而displayFrame可能比sourceCrop大,可能小,这都是正常的,只是需要做缩放,这就是合成时需要处理的。

而在外部Linux的Anbox中,上面rcEnc->rcPostLayer、rcEnc->rcPostAllLayersDone也是属于Anbox的RPC实现,这里只截取最终在Anbox中调用的地方,不多赘述。

//节选自vendor/anbox/src/anbox/graphics/emugl/RenderControl.cpp

void rcPostLayer(const char *name, uint32_t color_buffer, float alpha,

int32_t sourceCropLeft, int32_t sourceCropTop,

int32_t sourceCropRight, int32_t sourceCropBottom,

int32_t displayFrameLeft, int32_t displayFrameTop,

int32_t displayFrameRight, int32_t displayFrameBottom) {

//建立渲染结构体

Renderable r{

name,

color_buffer,

alpha,

{displayFrameLeft, displayFrameTop, displayFrameRight, displayFrameBottom},

{sourceCropLeft, sourceCropTop, sourceCropRight, sourceCropBottom}};

//发送给Anbox的Surface处理

frame_layers.push_back(r);

}

void rcPostAllLayersDone() {

if (composer) composer->submit_layers(frame_layers);

//提交Layer后刷新缓冲区

frame_layers.clear();

}

Gralloc模块

① 初步介绍

在android图形架构中,Gralloc属于低级别组件,用于给图形缓冲队列进行缓冲区分配,是一个内存分配器。其通过用法标志执行缓冲区分配。用法标志包括以下属性:

- 从软件 (CPU) 访问内存的频率

- 从硬件 (GPU) 访问内存的频率

- 是否将内存用作 OpenGL ES (GLES) 纹理

- 视频编码器是否会使用内存

例如,如果生产方的缓冲区格式指定 RGBA_8888 像素,并且生产方指明将从软件访问缓冲区,Gralloc将以R-G-B-A的顺序为每个像素创建一个4字节的缓冲区。如果情况相反,生产方指明仅从硬件访问其缓冲区且缓冲区作为 GLES 纹理,那么Gralloc可以做任何GLES驱动想要做的事情,比如BGRA排序、非线性swizzled布局和其他颜色格式。允许硬件使用其首选格式可以提高性能。

Gralloc 返回的句柄可以通过 Binder 在进程之间进行传递。

② Gralloc模块的重要实现

Gralloc在安卓中的实现

Gralloc主要定义了以HAL_MODULE_INFO_SYM为符号的类型为private_module_t的结构体

//节选自gralloc.cpp

static struct hw_module_methods_t gralloc_module_methods = {

.open = gralloc_device_open

};

struct private_module_t HAL_MODULE_INFO_SYM = {

.base = {

.common = {

.tag = HARDWARE_MODULE_TAG,

.version_major = 1,

.version_minor = 0,

.id = GRALLOC_HARDWARE_MODULE_ID,

.name = "Graphics Memory Allocator Module",

.author = "The Android Open Source Project",

.methods = &gralloc_module_methods

},

.registerBuffer = gralloc_register_buffer,

.unregisterBuffer = gralloc_unregister_buffer,

.lock = gralloc_lock,

.unlock = gralloc_unlock,

},

.framebuffer = 0,

.flags = 0,

.numBuffers = 0,

.bufferMask = 0,

.lock = PTHREAD_MUTEX_INITIALIZER,

.currentBuffer = 0,

};

private_module_t用于描述Gralloc模块下的系统帧缓冲区信息,主要作用是将图形缓冲区渲染到帧缓冲区。

//节选于gralloc/gralloc_priv.h

struct private_module_t {

gralloc_module_t base;

private_handle_t* framebuffer; //指向系统帧缓冲区的句柄

uint32_t flags; //用来标志系统帧缓冲区是否支持双缓冲

uint32_t numBuffers;//表示系统帧缓冲区包含有多少个图形缓冲区

uint32_t bufferMask; //记录系统帧缓冲区中的图形缓冲区的使用情况

pthread_mutex_t lock; //一个互斥锁,用来保护结构体private_module_t的并行访

buffer_handle_t currentBuffer; //用来描述当前正在被渲染的图形缓冲区

int pmem_master;

void* pmem_master_base;

struct fb_var_screeninfo info; //保存设备显示屏的动态属性信息

struct fb_fix_screeninfo finfo; //保存设备显示屏的固定属性信息

float xdpi; //描述设备显示屏在宽度

float ydpi; //描述设备显示屏在高度

float fps; //用来描述显示屏的刷新频率

};

gralloc_module_t用于描述gralloc模块信息,主要用于分配或者释放图形缓冲区。

//节选于hardware/gralloc.h

typedef struct gralloc_module_t {

struct hw_module_t common;

int (*registerBuffer)(struct gralloc_module_t const* module,

buffer_handle_t handle);//映射一块图形缓冲区到一个进程的地址空间去

int (*unregisterBuffer)(struct gralloc_module_t const* module,

buffer_handle_t handle);//取消映射一块图形缓冲区到一个进程的地址空间去

int (*lock)(struct gralloc_module_t const* module,

buffer_handle_t handle, int usage,

int l, int t, int w, int h,

void** vaddr);//锁定一个指定的图形缓冲区

int (*unlock)(struct gralloc_module_t const* module,

buffer_handle_t handle);//解锁一个指定的图形缓冲区

int (*perform)(struct gralloc_module_t const* module,

int operation, ... );

int (*lockAsync)(struct gralloc_module_t const* module,

buffer_handle_t handle, int usage,

int l, int t, int w, int h,

void** vaddr, int fenceFd);

int (*unlockAsync)(struct gralloc_module_t const* module,

buffer_handle_t handle, int* fenceFd);

int (*lockAsync_ycbcr)(struct gralloc_module_t const* module

buffer_handle_t handle, int usage,

int l, int t, int w, int h,

struct android_ycbcr *ycbcr, int fenceFd);

void* reserved_proc[3];

} gralloc_module_t;

alloc_device_t用于描述gralloc设备的信息。

//节选于hardware/gralloc.h

typedef struct alloc_device_t {

struct hw_device_t common;

int (*alloc)(struct alloc_device_t* dev,

int w, int h, int format, int usage,

buffer_handle_t* handle, int* stride);//用于分配一块图形缓冲区

int (*free)(struct alloc_device_t* dev,

buffer_handle_t handle);//用于释放指定的图形缓冲区

void (*dump)(struct alloc_device_t *dev, char *buff, int buff_len);

void* reserved_proc[7];

} alloc_device_t;

还有hw_module_t主要用于关联模块和设备,其在hardware.h被定义。

在gralloc.h中,还定义了GRALLOC_HARDWARE_GPU0设备,其主要是用于分配图形缓冲区,hw_module_t用于描述硬件抽象层Gralloc模块,而hw_device_t则用于描述硬件抽象层Gralloc设备,通过硬件抽象层设备可以找到对应的硬件抽象层模块。

图形缓冲区的结构则用private_handle_t来描述

//节选于gralloc/gralloc_priv.h

struct private_handle_t : public native_handle {

#else

struct private_handle_t {

struct native_handle nativeHandle;

#endif

enum {

PRIV_FLAGS_FRAMEBUFFER = 0x00000001

};

// file-descriptors

int fd; //指向一个文件描述符,这个文件描述符要么指向帧缓冲区设备,要么指向一块匿名共享内存

// ints

int magic;

int flags;//用来描述一个缓冲区的标志,当一个缓冲区的标志值等于PRIV_FLAGS_FRAMEBUFFER的时候,就表示它是在帧缓冲区中分配的。

int size;//用来描述一个缓冲区的大小

int offset;//用来描述一个缓冲区的偏移地址

// FIXME: the attributes below should be out-of-line

uint64_t base __attribute__((aligned(8)));//用来描述一个缓冲区的实际地址

int pid;//用来描述一个缓冲区的创建者的PID

GRALLOC_HARDWARE_GPU0设备使用结构体alloc_device_t来描述。结构体alloc_device_t有两个成员函数alloc和free,在上文当中[alloc_device_t用于描述gralloc设备的信息]已经提及。

//节选于hardware/gralloc.h

static inline int gralloc_open(const struct hw_module_t* module,

struct alloc_device_t** device) {

return module->methods->open(module,

GRALLOC_HARDWARE_GPU0, (struct hw_device_t**)device);

}

module指向的是一个用来描述Gralloc模块的hw_module_t结构体,它的成员变量methods所指向的一个hw_module_methods_t结构体的成员函数open指向了Gralloc模块中的函数gralloc_device_open。这里传入的设备名为GRALLOC_HARDWARE_GPU0,表示当前打开的是gpu设备。

下面这个函数主要是用来创建一个gralloc_context_t结构体,并且对它的成员变量device进行初始化。结构体gralloc_context_t的成员变量device的类型为gralloc_device_t,它用来描述一个gralloc设备。前面提到,gralloc设备是用来分配和释放图形缓冲区的,这是通过调用它的成员函数alloc和free来实现的。从这里可以看出,函数gralloc_device_open所打开的gralloc设备的成员函数alloc和free分别被设置为Gralloc模块中的函数gralloc_alloc和gralloc_free。

Gralloc主要就是通过上面两大函数来进行缓冲区的分配和释放。

//节选自gralloc.cpp

int gralloc_device_open(const hw_module_t* module, const char* name,

hw_device_t** device)

{

int status = -EINVAL;

if (!strcmp(name, GRALLOC_HARDWARE_GPU0)) {

gralloc_context_t *dev;

dev = (gralloc_context_t*)malloc(sizeof(*dev));

/* initialize our state here */

memset(dev, 0, sizeof(*dev));

/* initialize the procs */

dev->device.common.tag = HARDWARE_DEVICE_TAG; // 这是一个硬件模块标记

dev->device.common.version = 0;

dev->device.common.module = const_cast<hw_module_t*>(module);

dev->device.common.close = gralloc_close; // gralloc关闭

dev->device.alloc = gralloc_alloc; //分配图形缓冲区

dev->device.free = gralloc_free; // 释放图形缓冲区

*device = &dev->device.common;

status = 0;

} else {

status = fb_device_open(module, name, device);

}

return status;

}

Anbox部分重要实现

上面已经针对Gralloc模块基础进行来介绍,为了了解这一部分的实现原理,这里只关注整个Gralloc的HAL模块中Anbox注册的主要函数gralloc_alloc和gralloc_free进行介绍,而其中用于帧缓冲刷新的fb_post,Anbox并未实现。

gralloc_alloc及gralloc_free函数的实现

首先这里介绍gralloc_alloc以及gralloc_free函数,这里本质就是实现图形缓冲区的申请与释放,由于代码量较多,这里截取主要部分。

//节选自:vendor/anbox/android/opengl/system/gralloc/gralloc.cpp

//申请图形缓冲区

static int gralloc_alloc(alloc_device_t* dev,

int w, int h, int format, int usage,

buffer_handle_t* pHandle, int* pStride)

{

//当前gralloc设备

gralloc_device_t *grdev = (gralloc_device_t *)dev;

//一些标记,不同标记表面当前Gralloc申请的缓冲区的用途,比如用于camera的缓冲区

//

// Note: in screen capture mode, both sw_write and hw_write will be on

// and this is a valid usage

//

bool sw_write = (0 != (usage & GRALLOC_USAGE_SW_WRITE_MASK));

bool hw_write = (usage & GRALLOC_USAGE_HW_RENDER);

bool sw_read = (0 != (usage & GRALLOC_USAGE_SW_READ_MASK));

bool hw_cam_write = usage & GRALLOC_USAGE_HW_CAMERA_WRITE;

bool hw_cam_read = usage & GRALLOC_USAGE_HW_CAMERA_READ;

bool hw_vid_enc_read = usage & GRALLOC_USAGE_HW_VIDEO_ENCODER;

// 缓冲区大小,Anbox的这一模块是采用了ashmem这一共享内存来申请缓冲区

int ashmem_size = 0;

int stride = w;

GLenum glFormat = 0;

GLenum glType = 0;

int bpp = 0;

int align = 1;

// 针对各种图像格式选择不同的像素位数(bpp)大小、格式(glFormat)等配置信息

switch (format) {

case HAL_PIXEL_FORMAT_RGBA_8888:

case HAL_PIXEL_FORMAT_RGBX_8888:

case HAL_PIXEL_FORMAT_BGRA_8888:

bpp = 4;

glFormat = GL_RGBA;

glType = GL_UNSIGNED_BYTE;

break;

case HAL_PIXEL_FORMAT_RGB_888:

bpp = 3;

glFormat = GL_RGB;

glType = GL_UNSIGNED_BYTE;

break;

default:

ALOGE("gralloc_alloc: Unknown format %d", format);

return -EINVAL;

}

//针对不同用途给ashmem_size增加大小

if (sw_read || sw_write || hw_cam_write || hw_vid_enc_read) {

// keep space for image on guest memory if SW access is needed

// or if the camera is doing writing

if (yuv_format) {

size_t yStride = (w*bpp + (align - 1)) & ~(align-1);

size_t uvStride = (yStride / 2 + (align - 1)) & ~(align-1);

size_t uvHeight = h / 2;

ashmem_size += yStride * h + 2 * (uvHeight * uvStride);

stride = yStride / bpp;

} else {

size_t bpr = (w*bpp + (align-1)) & ~(align-1);

ashmem_size += (bpr * h);

stride = bpr / bpp;

}

}

//因为Anbox的实现没有实际图形硬件设备,从ashmem(Android 匿名共享内存,基于 mmap系统调用)申请图形缓冲区

//

// Allocate space in ashmem if needed

//

int fd = -1;

if (ashmem_size > 0) {

// 对齐page size;

ashmem_size = (ashmem_size + (PAGE_SIZE-1)) & ~(PAGE_SIZE-1);

// 申请gralloc-buffer区域的共享内存

fd = ashmem_create_region("gralloc-buffer", ashmem_size);

if (fd < 0) {

ALOGE("gralloc_alloc failed to create ashmem region: %s\n",

strerror(errno));

return -errno;

}

}

// 建立给申请方的回调

cb_handle_t *cb = new cb_handle_t(fd, ashmem_size, usage, w, h, frameworkFormat, format, glFormat, glType);

if (ashmem_size > 0) {

// 申请到了就map这片区域

//

// map ashmem region if exist

//

void *vaddr;

int err = map_buffer(cb, &vaddr);

if (err) {

close(fd);

delete cb;

return err;

}

// map成功就更新fd给回调

cb->setFd(fd);

}

// 这里是如果有一些情况需要回传Anbox在主机侧Surface的数据,比如需要录屏的时候就需要这种情况

//

// Allocate ColorBuffer handle on the host (only if h/w access is allowed)

// Only do this for some h/w usages, not all.

// Also do this if we need to read from the surface, in this case the

// rendering will still happen on the host but we also need to be able to

// read back from the color buffer, which requires that there is a buffer

//

if (usage & (GRALLOC_USAGE_HW_TEXTURE | GRALLOC_USAGE_HW_RENDER |

GRALLOC_USAGE_HW_2D | GRALLOC_USAGE_HW_COMPOSER |

GRALLOC_USAGE_HW_FB | GRALLOC_USAGE_SW_READ_MASK) ) {

DEFINE_HOST_CONNECTION;

// 建立QEMU_PIPE连接后获取Anbox端的数据,这里是建立Anbox端的Buffer,否则Anbox那边会丢掉。创建了就会把Handle返回给相关接口以便调用。

if (hostCon && rcEnc) {

cb->hostHandle = rcEnc->rcCreateColorBuffer(rcEnc, w, h, glFormat);

D("Created host ColorBuffer 0x%x\n", cb->hostHandle);

}

if (!cb->hostHandle) {

// Could not create colorbuffer on host !!!

close(fd);

delete cb;

return -EIO;

}

}

// 申请成功,把相关东西返回给对应接口,把申请的handle插入到已申请的列表(链表)

//

// alloc succeeded - insert the allocated handle to the allocated list

//

AllocListNode *node = new AllocListNode();

pthread_mutex_lock(&grdev->lock); // 互斥锁

// 临界区

node->handle = cb;

node->next = grdev->allocListHead;

node->prev = NULL; //单向链表

// 链表头插法

if (grdev->allocListHead) {

grdev->allocListHead->prev = node;

}

grdev->allocListHead = node;

pthread_mutex_unlock(&grdev->lock); //退出临界区,取消互斥锁

*pHandle = cb;

return 0;

}

//释放图形缓冲区

static int gralloc_free(alloc_device_t* dev,

buffer_handle_t handle)

{

const cb_handle_t *cb = (const cb_handle_t *)handle;

if (!cb_handle_t::validate((cb_handle_t*)cb)) {

ERR("gralloc_free: invalid handle");

return -EINVAL;

}

// 如果该Handle有在外部Anbox上的ColorBuffer,连接QEMU_PIPE并释放它。

if (cb->hostHandle != 0) {

DEFINE_AND_VALIDATE_HOST_CONNECTION;

D("Closing host ColorBuffer 0x%x\n", cb->hostHandle);

rcEnc->rcCloseColorBuffer(rcEnc, cb->hostHandle);

}

// 释放ashmem申请的区域

//

// detach and unmap ashmem area if present

//

if (cb->fd > 0) {

if (cb->ashmemSize > 0 && cb->ashmemBase) {

munmap((void *)cb->ashmemBase, cb->ashmemSize);

}

close(cb->fd);

}

// 从已申请的列表(链表实现)移除

// remove it from the allocated list

gralloc_device_t *grdev = (gralloc_device_t *)dev;

pthread_mutex_lock(&grdev->lock); // 互斥锁

// 进入临界区

AllocListNode *n = grdev->allocListHead;

// 找到链表中对应这个Handle

while( n && n->handle != cb ) {

n = n->next;

}

if (n) {

// buffer found on list - remove it from list

// 把Handle移出链表

if (n->next) {

n->next->prev = n->prev;

}

if (n->prev) {

n->prev->next = n->next;

}

else {

grdev->allocListHead = n->next;

}

delete n;

}

pthread_mutex_unlock(&grdev->lock); //退出临界区,取消互斥锁

delete cb;

return 0;

}

以上gralloc_alloc实现了图形缓冲区的申请,gralloc_free实现了缓冲区释放,但是在Anbox中,由于没有实际的图形硬件设备,其图形部分均由软件实现,因此其与图形缓冲区的相关实现均也由软件实现。与之相对应的,实际手机硬件中,这里的缓冲区是来自于硬件,例如通过FrameBuffer或者DRM显示设备进行申请等。

由于Anbox的图形缓冲区是软件实现的,同时在渲染的画面均在Linux这边的Anbox上实现的,这一实现便有了缺点,例如DRM的实现可以通过硬件DMA对图形缓冲器进行处理,而Anbox的软件实现只能靠CPU进行内存拷贝,尤其在录屏的情况下,屏幕数据需要让CPU拷贝到外部进行合成显示,又需要拷贝回来再让编码器进行编码,两趟拷贝浪费了许多CPU与内存的性能。

3.1.2 参考资料

- 自上而下解读Android显示流程(中上) - 知乎 (zhihu.com)

- Android图形系统系统篇之HWC_leontli的博客-CSDN博客_setclienttarget

- Andorid 硬件显示系统HWC&HWC2架构详解_coloriy的博客-CSDN博客_android display hwc

3.2 Anbox图形渲染实现

3.2.1 Anbox图形渲染相关组件

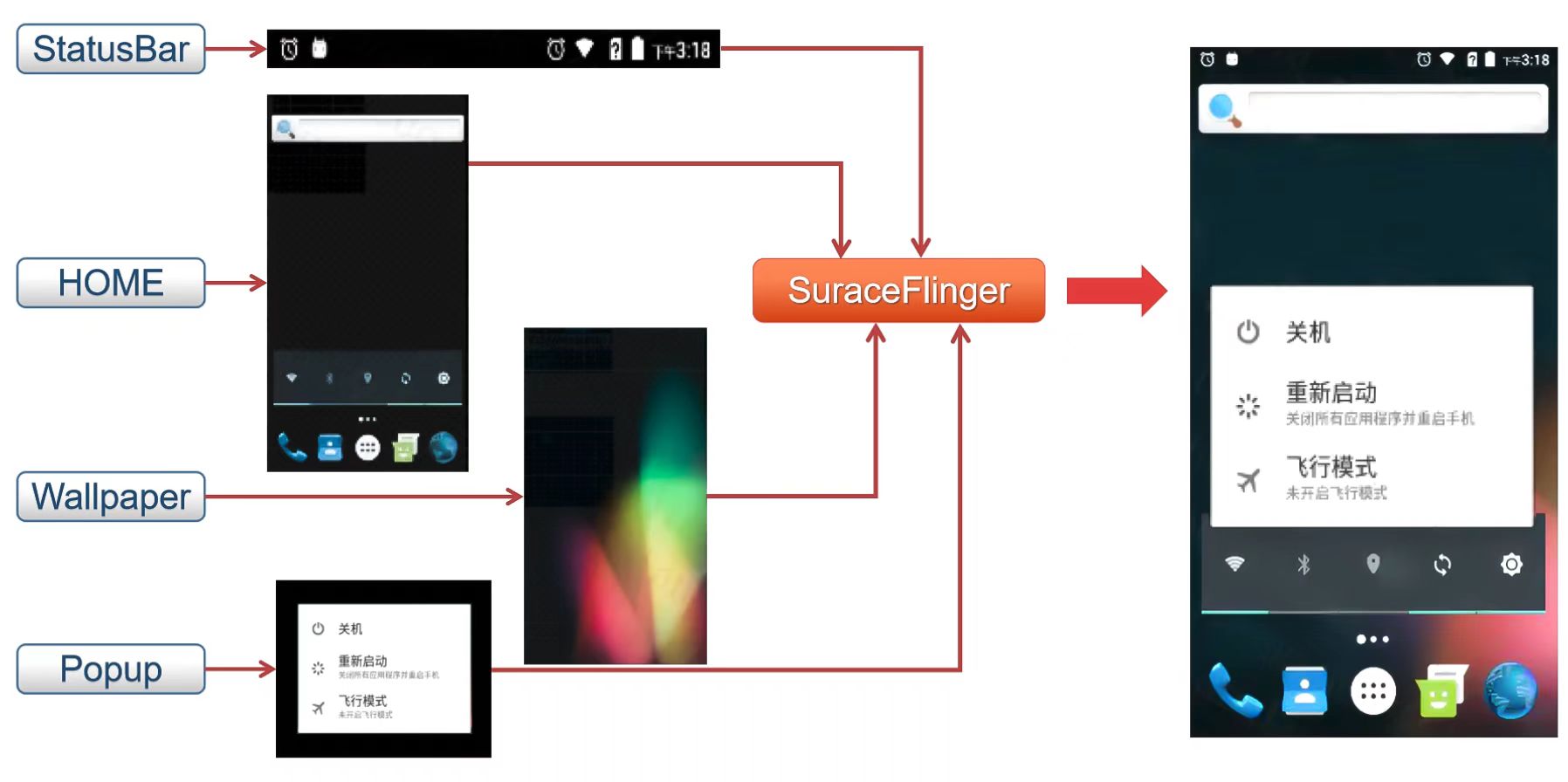

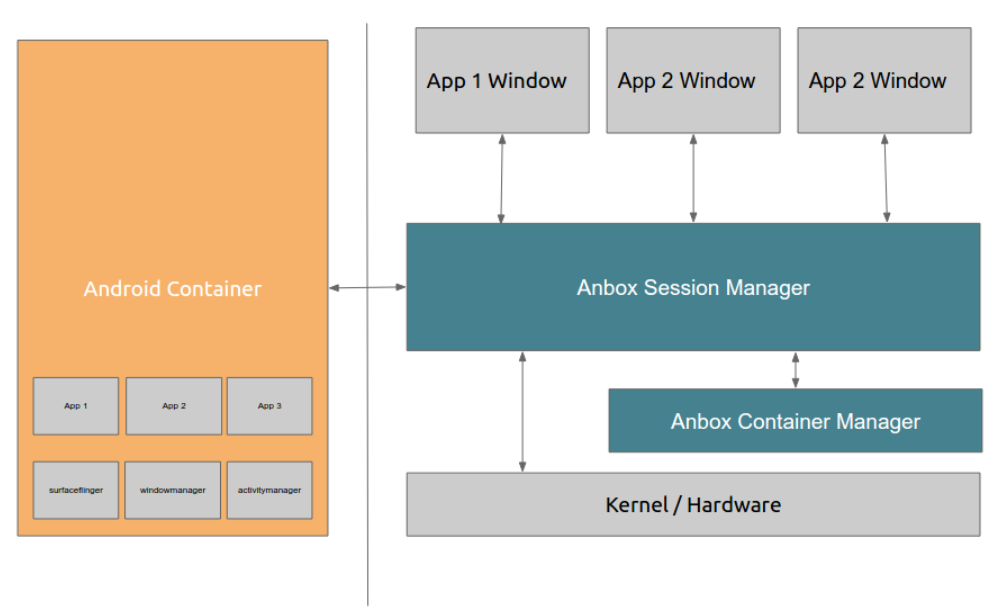

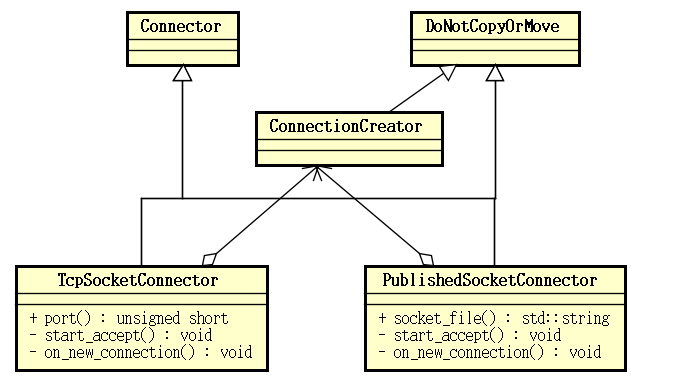

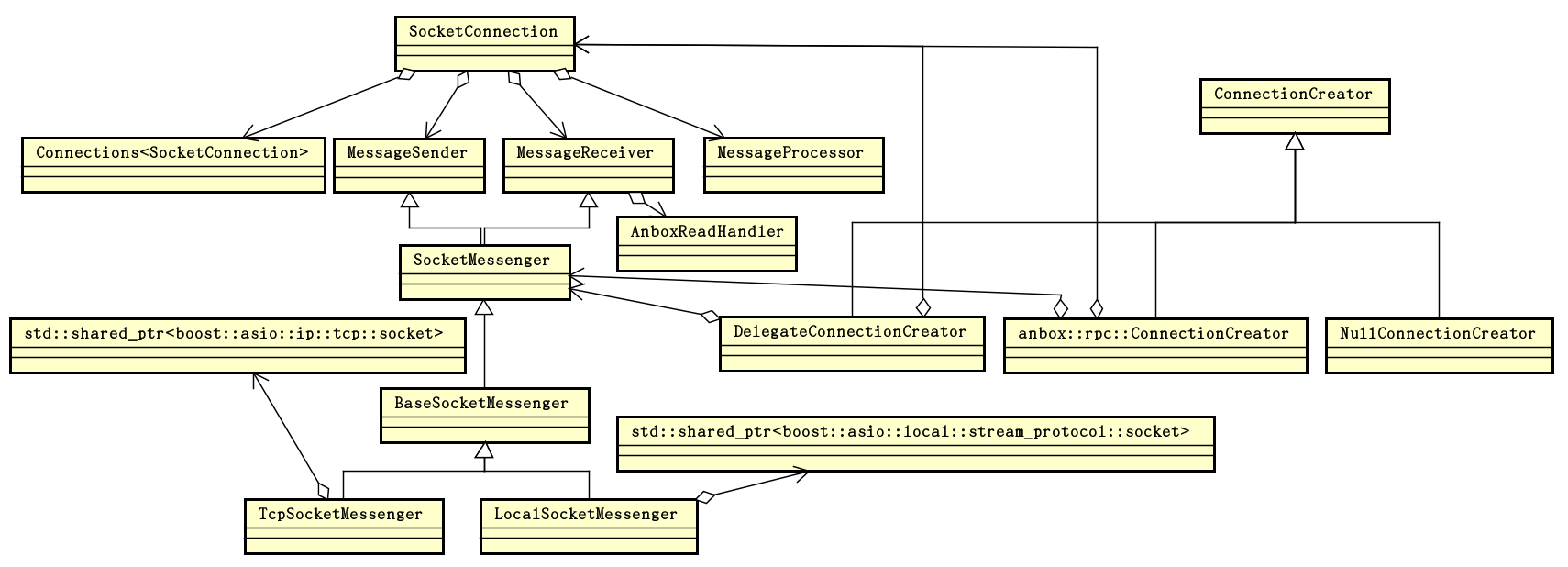

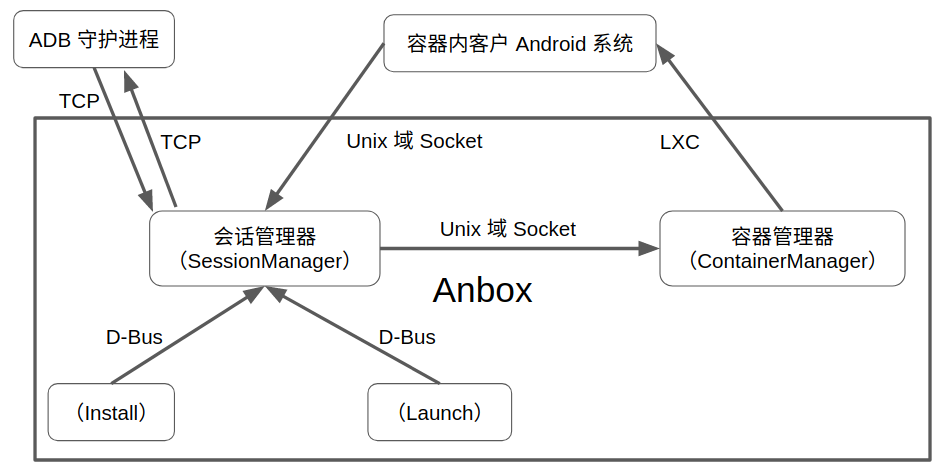

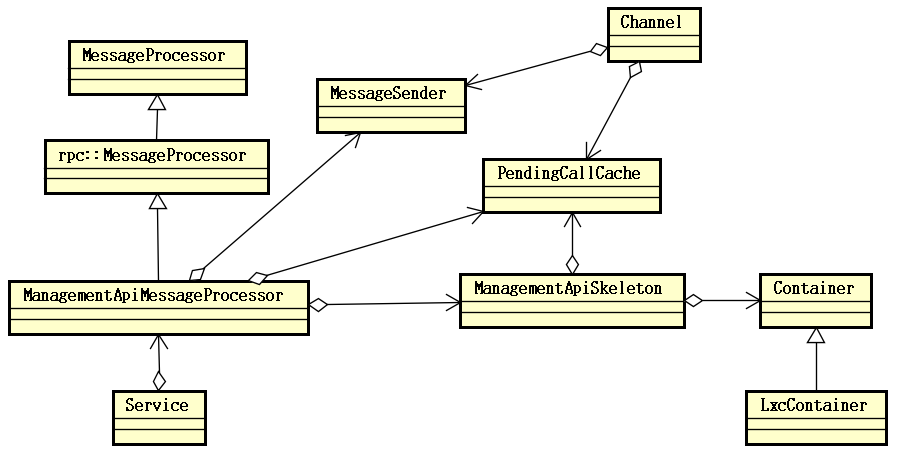

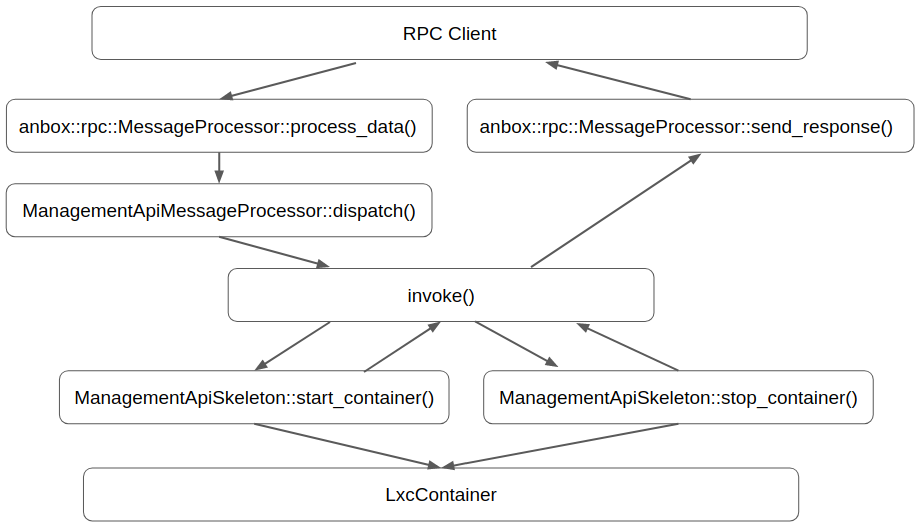

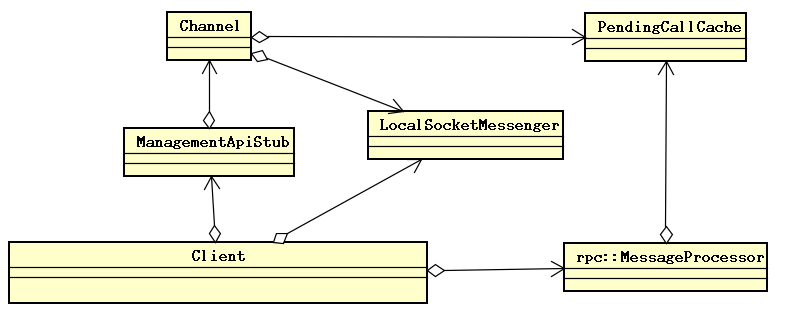

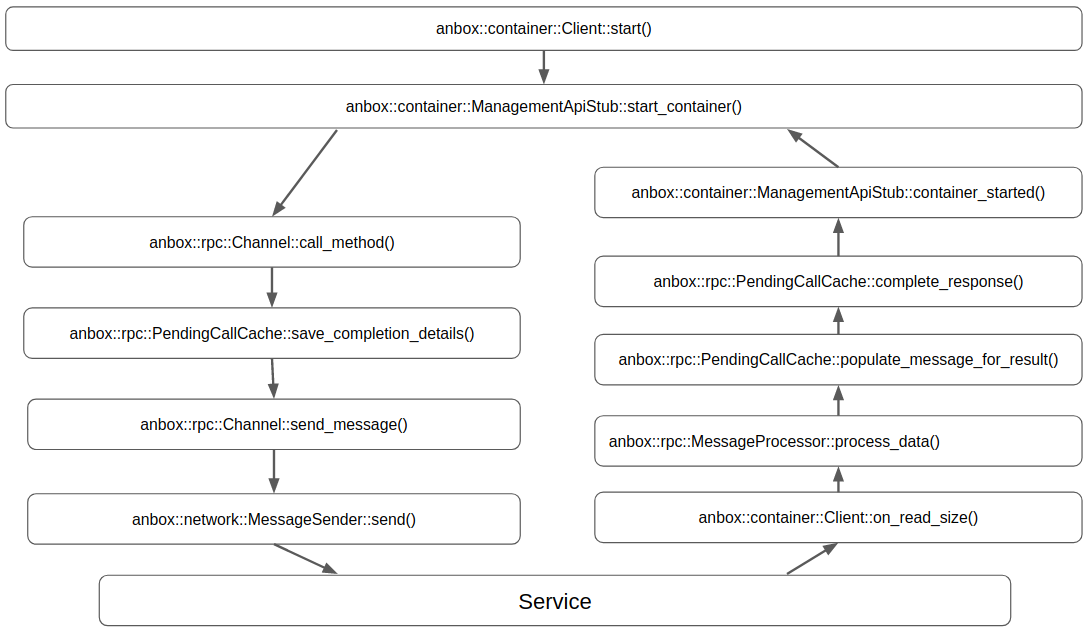

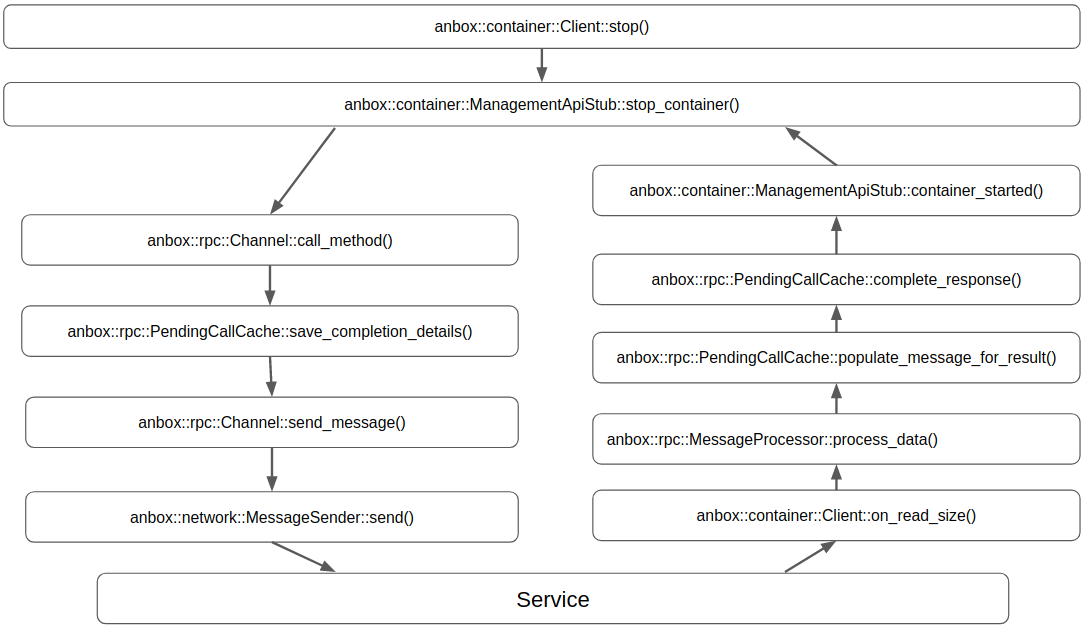

如图3.6便是Anbox官方给出的架构图,从图中可以看到,Anbox主要有两个部分:Session Manager和Container Manager(Container Manager部分内容不在本文分析范围内)。其中Session Manager主要做了以下三部分工作:

(1) 虚拟Surfaceflinger

Surfaceflinger即Android的图像系统,可以将Android里的不同应用渲染的结构进行图层的合成,使得所有应用的渲染结果最终合成在一个窗口上。

(2) 虚拟Windowmanager

Windowmanager是指Android的窗口管理器,功能是给Android里的应用提供对应的窗口,即给每个应用提供自己的渲染界面。

(3) 虚拟Activitymanager

Activitymanager是指管理Android内部的进程管理器,主要功能是管理应用的启动、关闭等进程。

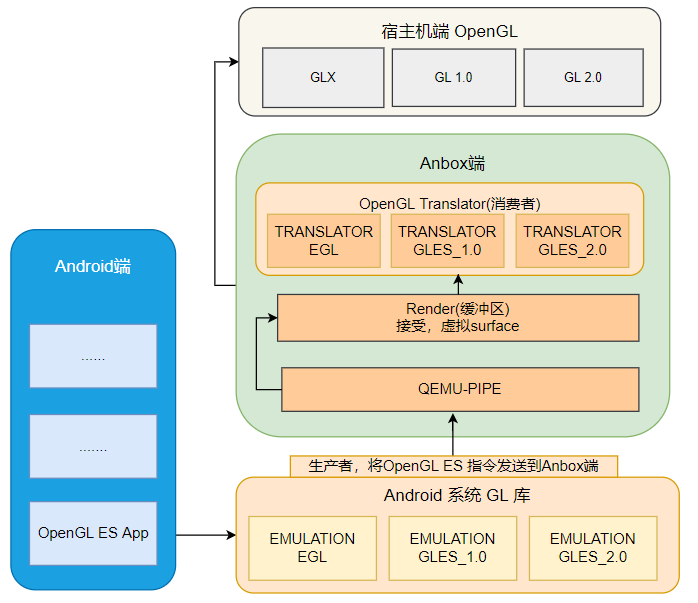

本文主要从Android端中的OpenGL ES初始化开始分析,到最终的指令经过Anbox端的翻译库进行翻译,最终由宿主机端的OpenGL进行图形渲染。下图为具体实现流程图:

3.2.2 OpenGL ES

Anbox的图形渲染部分实现与OpenGL ES息息相关,其实现了在Android模拟OpenGL相关库,接收相关指令并传输出去。下文将对OpenGL ES相关实现进行分析,在了解OpenGL ES之前,我们需要先了解什么是OpenGL。

(1) 什么是OpenGL

OpenGL是一套图像编程接口,对于开发者来说,其实就是一套C语言编写的API接口,通过这些接口,开发者可以调用显卡来进行计算机的图形开发。虽然OpenGL是一套API接口,但它并没有具体实现这些接口,接口的实现是由显卡的驱动程序来完成的。显卡驱动也是其他模块和显卡沟通的入口,开发者通过调用OpenGL的图像编程接口发出渲染命令,这些渲染命令被称为DrawCall,显卡驱动会将渲染命令翻译能被GPU理解的指令,然后通知GPU读取数据进行操作。

(2) 什么是OpenGL ES

OpenGL ES又是什么呢?它是为了更好地适应嵌入式等硬件较差的设备,推出的OpenGL的剪裁版,基本和OpenGL是一致的。Android从4.0开始默认开启硬件加速,也就是默认使用OpenGL ES来进行图形的生成和渲染工作。

(3) 如何使用OpenGL ES

了解Android如何使用OpenGL ES前,需要先对EGL有个简单了解,在本文中不涉及对EGL的深入分析。OpenGL虽然是跨平台的,但是在各个平台上也不能直接使用,因为每个平台的窗口都是不一样的,而EGL就是适配Android本地窗口系统和OpenGL ES桥接层。

OpenGL ES 定义了平台无关的 GL 绘图指令,EGL则定义了控制 displays,contexts 以及 surfaces 的统一的平台接口。

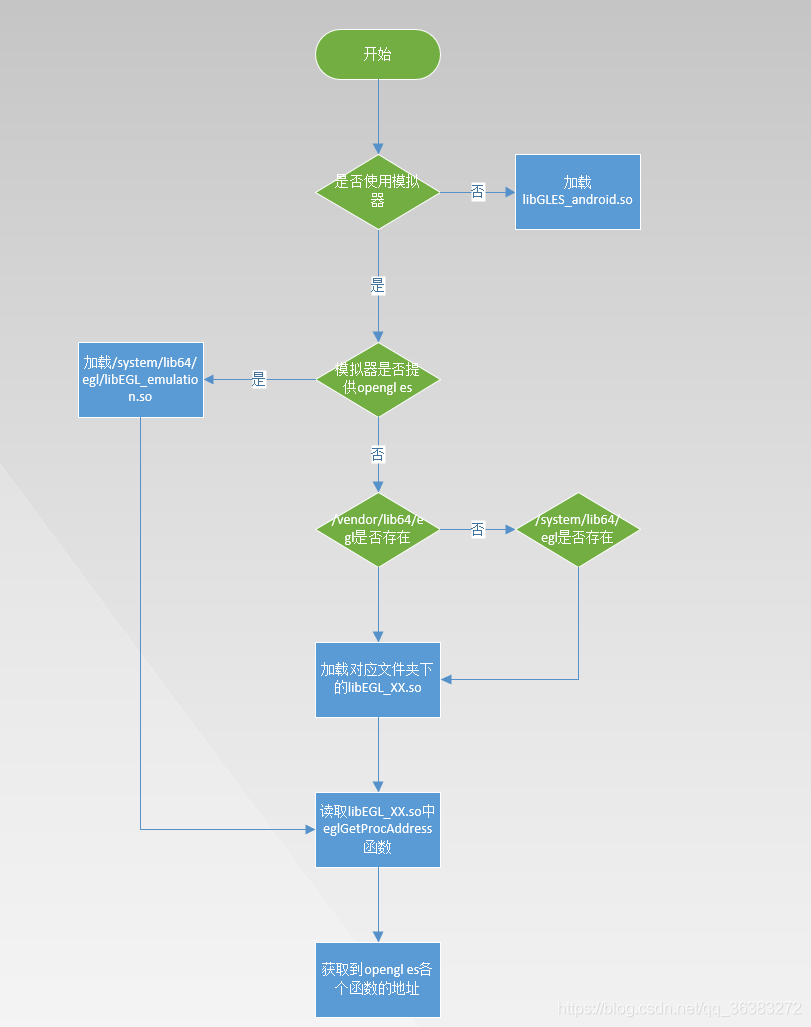

① 初始化与加载

Android7 加载OpenGL ES和EGL的源码在/frameworks/native/opengl/libs/EGL/。

当eglGetDisplay被调用时,OpenGL 的库文件就被加载了,具体过程是:

EGL初始化

EGLDisplay eglGetDisplay(EGLNativeDisplayType display)//获取设备屏幕

EGLBoolean eglInitialize(EGLDisplay display, // 指定EGL显示连接

EGLint *majorVersion, // 指定 EGL实现返回的 主版本号,可能为NULL

EGLint *minorVersion); // 返回 EGL实现返回的 次版本号,可能为NUL

在EGL初始化过程中调用了OpenGL初始化函数Loader::open:

static EGLBoolean egl_init_drivers_locked() {

if (sEarlyInitState) {

// initialized by static ctor. should be set here.

return EGL_FALSE;

}

// get our driver loader

Loader& loader(Loader::getInstance());

// dynamically load our EGL implementation

egl_connection_t* cnx = &gEGLImpl;

if (cnx->dso == 0) {

cnx->hooks[egl_connection_t::GLESv1_INDEX] =

&gHooks[egl_connection_t::GLESv1_INDEX];

cnx->hooks[egl_connection_t::GLESv2_INDEX] =

&gHooks[egl_connection_t::GLESv2_INDEX];

//调用初始化OpenGL函数

cnx->dso = loader.open(cnx);

}

return cnx->dso ? EGL_TRUE : EGL_FALSE;

}

OpenGL ES初始化

Loader::open(egl_connection_t* cnx) 初始化图形驱动,主要是初始化这些函数表和指针。Loader::open(egl_connection_t* cnx) 的定义如下。

static void* load_wrapper(const char* path) {

void* so = dlopen(path, RTLD_NOW | RTLD_LOCAL);

ALOGE_IF(!so, "dlopen(\"%s\") failed: %s", path, dlerror());

return so;

}

#ifndef EGL_WRAPPER_DIR

#if defined(__LP64__)

#define EGL_WRAPPER_DIR "/system/lib64"

#else

#define EGL_WRAPPER_DIR "/system/lib"

#endif

#endif

//设置模拟器属性(是否在模拟器中运行?在模拟中运行时是否有GPU支持?)

static void setEmulatorGlesValue(void) {

char prop[PROPERTY_VALUE_MAX];

property_get("ro.kernel.qemu", prop, "0");

if (atoi(prop) != 1) return;

property_get("ro.kernel.qemu.gles",prop,"0");

if (atoi(prop) == 1) {

ALOGD("Emulator has host GPU support, qemu.gles is set to 1.");

property_set("qemu.gles", "1");

return;

}

// for now, checking the following

// directory is good enough for emulator system images

const char* vendor_lib_path =

//NDK编译后的库不同手机上运行,可能加载的是 32 位 的 或者 64 的 库

#if defined(__LP64__)

"/vendor/lib64/egl";

#else

"/vendor/lib/egl";

#endif

//判断库文件是否存在

const bool has_vendor_lib = (access(vendor_lib_path, R_OK) == 0);

if (has_vendor_lib) {

//存在则表示模拟器被GPU支持,通过客户的OpenGLES 实现

ALOGD("Emulator has vendor provided software renderer, qemu.gles is set to 2.");

//设置qemu.gles值为2

property_set("qemu.gles", "2");

} else {

//模拟器不被GPU所支持,设置qemu.gles值为0

ALOGD("Emulator without GPU support detected. "

"Fallback to legacy software renderer, qemu.gles is set to 0.");

property_set("qemu.gles", "0");

}

}

void* Loader::open(egl_connection_t* cnx)

{

void* dso;

driver_t* hnd = 0;

// 设置模拟器属性(是否在模拟器中运行?在模拟中运行时是否有GPU支持?)

setEmulatorGlesValue();

//加载设备特有的图形驱动库,包括 EGL 库,OpenGL ES 1.0 和 2.0 的库。

dso = load_driver("GLES", cnx, EGL | GLESv1_CM | GLESv2);

if (dso) {

hnd = new driver_t(dso);

} else {

// Always load EGL first

dso = load_driver("EGL", cnx, EGL);

if (dso) {

hnd = new driver_t(dso);

hnd->set( load_driver("GLESv1_CM", cnx, GLESv1_CM), GLESv1_CM );

hnd->set( load_driver("GLESv2", cnx, GLESv2), GLESv2 );

}

}

LOG_ALWAYS_FATAL_IF(!hnd, "couldn't find an OpenGL ES implementation");

//加载图形驱动 Wrapper,它们都位于 /system/lib64 或 /system/lib

cnx->libEgl = load_wrapper(EGL_WRAPPER_DIR "/libEGL.so");

cnx->libGles2 = load_wrapper(EGL_WRAPPER_DIR "/libGLESv2.so");

cnx->libGles1 = load_wrapper(EGL_WRAPPER_DIR "/libGLESv1_CM.so");

LOG_ALWAYS_FATAL_IF(!cnx->libEgl,

"couldn't load system EGL wrapper libraries");

LOG_ALWAYS_FATAL_IF(!cnx->libGles2 || !cnx->libGles1,

"couldn't load system OpenGL ES wrapper libraries");

return (void*)hnd;

}

这里的driver_t是Loader类的内部结构体:

struct driver_t {

explicit driver_t(void* gles);

~driver_t();

status_t set(void* hnd, int32_t api);

void* dso[3];

};

struct driver_t 包含设备生产商提供的设备特有 EGL 和 OpenGL ES 实现库的句柄,如果 EGL 接口和 OpenGL 接口由单独的库实现,它包含一个库的句柄,即这个单独的库,如果 EGL 接口由不同的库实现,它则包含所有这些库的句柄。

在open函数中还调用了setEmulatorGlesValue函数,这个函数用于检查、设置一些模拟器属性(例如是否在模拟器中运行以及在模拟运行时是否有GPU支持)。

Loader::load_driver()函数主要完成驱动库加载,以下是相关代码,加载驱动库可细分为三步进行:

/* This function is called to check whether we run inside the emulator,

* and if this is the case whether GLES GPU emulation is supported.

*

* Returned values are:

* -1 -> not running inside the emulator

* 0 -> running inside the emulator, but GPU emulation not supported

* 1 -> running inside the emulator, GPU emulation is supported

* through the "emulation" host-side OpenGL ES implementation.

* 2 -> running inside the emulator, GPU emulation is supported

* through a guest-side vendor driver's OpenGL ES implementation.

*/

static int

checkGlesEmulationStatus(void)

{

/* We're going to check for the following kernel parameters:

*

* qemu=1 -> tells us that we run inside the emulator

* android.qemu.gles=<number> -> tells us the GLES GPU emulation status

*

* Note that we will return <number> if we find it. This let us support

* more additionnal emulation modes in the future.

*/

char prop[PROPERTY_VALUE_MAX];

int result = -1;

/* First, check for qemu=1 */

property_get("ro.kernel.qemu",prop,"0");

if (atoi(prop) != 1)

return -1;

/* We are in the emulator, get GPU status value */

property_get("qemu.gles",prop,"0");

return atoi(prop);

}

. . . . . .

void Loader::init_api(void* dso,

char const * const * api,

__eglMustCastToProperFunctionPointerType* curr,

getProcAddressType getProcAddress)

{

const ssize_t SIZE = 256;

char scrap[SIZE];

while (*api) {

char const * name = *api;

__eglMustCastToProperFunctionPointerType f =

(__eglMustCastToProperFunctionPointerType)dlsym(dso, name);

if (f == NULL) {

// couldn't find the entry-point, use eglGetProcAddress()

f = getProcAddress(name);

}

if (f == NULL) {

// Try without the OES postfix

ssize_t index = ssize_t(strlen(name)) - 3;

if ((index>0 && (index<SIZE-1)) && (!strcmp(name+index, "OES"))) {

strncpy(scrap, name, index);

scrap[index] = 0;

f = (__eglMustCastToProperFunctionPointerType)dlsym(dso, scrap);

//ALOGD_IF(f, "found <%s> instead", scrap);

}

}

if (f == NULL) {

// Try with the OES postfix

ssize_t index = ssize_t(strlen(name)) - 3;

if (index>0 && strcmp(name+index, "OES")) {

snprintf(scrap, SIZE, "%sOES", name);

f = (__eglMustCastToProperFunctionPointerType)dlsym(dso, scrap);

//ALOGD_IF(f, "found <%s> instead", scrap);

}

}

if (f == NULL) {

//ALOGD("%s", name);

f = (__eglMustCastToProperFunctionPointerType)gl_unimplemented;

/*

* GL_EXT_debug_label is special, we always report it as

* supported, it's handled by GLES_trace. If GLES_trace is not

* enabled, then these are no-ops.

*/

if (!strcmp(name, "glInsertEventMarkerEXT")) {

f = (__eglMustCastToProperFunctionPointerType)gl_noop;

} else if (!strcmp(name, "glPushGroupMarkerEXT")) {

f = (__eglMustCastToProperFunctionPointerType)gl_noop;

} else if (!strcmp(name, "glPopGroupMarkerEXT")) {

f = (__eglMustCastToProperFunctionPointerType)gl_noop;

}

}

*curr++ = f;

api++;

}

}

void *Loader::load_driver(const char* kind,

egl_connection_t* cnx, uint32_t mask)

{

class MatchFile {

public:

static String8 find(const char* kind) {

String8 result;

int emulationStatus = checkGlesEmulationStatus();

switch (emulationStatus) {

case 0:

#if defined(__LP64__)

result.setTo("/system/lib64/egl/libGLES_android.so");

#else

result.setTo("/system/lib/egl/libGLES_android.so");

#endif

return result;

case 1:

// Use host-side OpenGL through the "emulation" library

#if defined(__LP64__)

result.appendFormat("/system/lib64/egl/lib%s_emulation.so", kind);

#else

result.appendFormat("/system/lib/egl/lib%s_emulation.so", kind);

#endif

return result;

default:

// Not in emulator, or use other guest-side implementation

break;

}

String8 pattern;

pattern.appendFormat("lib%s", kind);

const char* const searchPaths[] = {

#if defined(__LP64__)

"/vendor/lib64/egl",

"/system/lib64/egl"

#else

"/vendor/lib/egl",

"/system/lib/egl"

#endif

};

// first, we search for the exact name of the GLES userspace

// driver in both locations.

// i.e.:

// libGLES.so, or:

// libEGL.so, libGLESv1_CM.so, libGLESv2.so

for (size_t i=0 ; i<NELEM(searchPaths) ; i++) {

if (find(result, pattern, searchPaths[i], true)) {

return result;

}

}

// for compatibility with the old "egl.cfg" naming convention

// we look for files that match:

// libGLES_*.so, or:

// libEGL_*.so, libGLESv1_CM_*.so, libGLESv2_*.so

pattern.append("_");

for (size_t i=0 ; i<NELEM(searchPaths) ; i++) {

if (find(result, pattern, searchPaths[i], false)) {

return result;

}

}

// we didn't find the driver. gah.

result.clear();

return result;

}

private:

static bool find(String8& result,

const String8& pattern, const char* const search, bool exact) {

if (exact) {

String8 absolutePath;

absolutePath.appendFormat("%s/%s.so", search, pattern.string());

if (!access(absolutePath.string(), R_OK)) {

result = absolutePath;

return true;

}

return false;

}

DIR* d = opendir(search);

if (d != NULL) {

struct dirent cur;

struct dirent* e;

while (readdir_r(d, &cur, &e) == 0 && e) {

if (e->d_type == DT_DIR) {

continue;

}

if (!strcmp(e->d_name, "libGLES_android.so")) {

// always skip the software renderer

continue;

}

if (strstr(e->d_name, pattern.string()) == e->d_name) {

if (!strcmp(e->d_name + strlen(e->d_name) - 3, ".so")) {

result.clear();

result.appendFormat("%s/%s", search, e->d_name);

closedir(d);

return true;

}

}

}

closedir(d);

}

return false;

}

};

String8 absolutePath = MatchFile::find(kind);

if (absolutePath.isEmpty()) {

// this happens often, we don't want to log an error

return 0;

}

const char* const driver_absolute_path = absolutePath.string();

void* dso = dlopen(driver_absolute_path, RTLD_NOW | RTLD_LOCAL);

if (dso == 0) {

const char* err = dlerror();

ALOGE("load_driver(%s): %s", driver_absolute_path, err?err:"unknown");

return 0;

}

if (mask & EGL) {

ALOGD("EGL loaded %s", driver_absolute_path);

getProcAddress = (getProcAddressType)dlsym(dso, "eglGetProcAddress");

ALOGE_IF(!getProcAddress,

"can't find eglGetProcAddress() in %s", driver_absolute_path);

egl_t* egl = &cnx->egl;

__eglMustCastToProperFunctionPointerType* curr =

(__eglMustCastToProperFunctionPointerType*)egl;

char const * const * api = egl_names;

while (*api) {

char const * name = *api;

__eglMustCastToProperFunctionPointerType f =

(__eglMustCastToProperFunctionPointerType)dlsym(dso, name);

if (f == NULL) {

// couldn't find the entry-point, use eglGetProcAddress()

f = getProcAddress(name);

if (f == NULL) {

f = (__eglMustCastToProperFunctionPointerType)0;

}

}

*curr++ = f;

api++;

}

}

if (mask & GLESv1_CM) {

ALOGD("GLESv1_CM loaded %s", driver_absolute_path);

init_api(dso, gl_names,

(__eglMustCastToProperFunctionPointerType*)

&cnx->hooks[egl_connection_t::GLESv1_INDEX]->gl,

getProcAddress);

}

if (mask & GLESv2) {

ALOGD("GLESv2 loaded %s", driver_absolute_path);

init_api(dso, gl_names,

(__eglMustCastToProperFunctionPointerType*)

&cnx->hooks[egl_connection_t::GLESv2_INDEX]->gl,

getProcAddress);

}

return dso;

}

第一步,找到驱动库文件的路径:

class MatchFile {

public:

static String8 find(const char* kind) {

String8 result;

int emulationStatus = checkGlesEmulationStatus();

switch (emulationStatus) {

case 0:

#if defined(__LP64__)

result.setTo("/system/lib64/egl/libGLES_android.so");

#else

result.setTo("/system/lib/egl/libGLES_android.so");

#endif

return result;

case 1:

// Use host-side OpenGL through the "emulation" library

#if defined(__LP64__)

result.appendFormat("/system/lib64/egl/lib%s_emulation.so", kind);

#else

result.appendFormat("/system/lib/egl/lib%s_emulation.so", kind);

#endif

return result;

default:

// Not in emulator, or use other guest-side implementation

break;

}

String8 pattern;

pattern.appendFormat("lib%s", kind);

const char* const searchPaths[] = {

#if defined(__LP64__)

"/vendor/lib64/egl",

"/system/lib64/egl"

#else

"/vendor/lib/egl",

"/system/lib/egl"

#endif

};

// first, we search for the exact name of the GLES userspace

// driver in both locations.

// i.e.:

// libGLES.so, or:

// libEGL.so, libGLESv1_CM.so, libGLESv2.so

for (size_t i=0 ; i<NELEM(searchPaths) ; i++) {

if (find(result, pattern, searchPaths[i], true)) {

return result;

}

}

// for compatibility with the old "egl.cfg" naming convention

// we look for files that match:

// libGLES_*.so, or:

// libEGL_*.so, libGLESv1_CM_*.so, libGLESv2_*.so

pattern.append("_");

for (size_t i=0 ; i<NELEM(searchPaths) ; i++) {

if (find(result, pattern, searchPaths[i], false)) {

return result;

}

}

// we didn't find the driver. gah.

result.clear();

return result;

}

private:

static bool find(String8& result,

const String8& pattern, const char* const search, bool exact) {

if (exact) {

String8 absolutePath;

absolutePath.appendFormat("%s/%s.so", search, pattern.string());

if (!access(absolutePath.string(), R_OK)) {

result = absolutePath;

return true;

}

return false;

}

DIR* d = opendir(search);

if (d != NULL) {

struct dirent cur;

struct dirent* e;

while (readdir_r(d, &cur, &e) == 0 && e) {

if (e->d_type == DT_DIR) {

continue;

}

if (!strcmp(e->d_name, "libGLES_android.so")) {

// always skip the software renderer

continue;

}

if (strstr(e->d_name, pattern.string()) == e->d_name) {

if (!strcmp(e->d_name + strlen(e->d_name) - 3, ".so")) {

result.clear();

result.appendFormat("%s/%s", search, e->d_name);

closedir(d);

return true;

}

}

}

closedir(d);

}

return false;

}

};

String8 absolutePath = MatchFile::find(kind);

if (absolutePath.isEmpty()) {

// this happens often, we don't want to log an error

return 0;

}

对于使用模拟器即使用 GLES 软件渲染模拟的情况,EGL 和 OpenGL ES 库对应为 /system/lib64/egl/libGLES_android.so 或 /system/lib/egl/libGLES_android.so。

如果使用物理设备,那么对于特定图形驱动库文件,EGL 库文件或 OpenGL ES 库文件查找则按照如下的顺序进行加载:

① /vendor/lib64/egl 或 /vendor/lib/egl 目录下文件名符合 lib*.so 模式的库文件,例如 /vendor/lib64/egl/libGLES.so。

② /system/lib64/egl 或 /system/lib/egl 目录下文件名符合 lib*.so 模式的库文件,例如 /system/lib64/egl/libGLES.so。

③ /vendor/lib64/egl 或 /vendor/lib/egl 目录下文件名符合 lib_*.so 模式的库文件,例如针对于 Pixel 设备的 /vendor/lib64/egl/libEGL_adreno.so。

④ /system/lib64/egl 或 /system/lib/egl 目录下文件名符合 lib_*.so 模式的库文件。

也就是说Android 会优先采用 /vendor/ 下设备供应商提供的图形驱动库。

第二步,通过 dlopen函数加载库文件:

const char* const driver_absolute_path = absolutePath.string();

void* dso = dlopen(driver_absolute_path, RTLD_NOW | RTLD_LOCAL);

if (dso == 0) {

const char* err = dlerror();

ALOGE("load_driver(%s): %s", driver_absolute_path, err?err:"unknown");

return 0;

}

第三步,初始化函数表:

if (mask & EGL) {

ALOGD("EGL loaded %s", driver_absolute_path);

getProcAddress = (getProcAddressType)dlsym(dso, "eglGetProcAddress");

ALOGE_IF(!getProcAddress,

"can't find eglGetProcAddress() in %s", driver_absolute_path);

egl_t* egl = &cnx->egl;

__eglMustCastToProperFunctionPointerType* curr =

(__eglMustCastToProperFunctionPointerType*)egl;

char const * const * api = egl_names;

while (*api) {

char const * name = *api;

__eglMustCastToProperFunctionPointerType f =

(__eglMustCastToProperFunctionPointerType)dlsym(dso, name);

if (f == NULL) {

// couldn't find the entry-point, use eglGetProcAddress()

f = getProcAddress(name);

if (f == NULL) {

f = (__eglMustCastToProperFunctionPointerType)0;

}

}

*curr++ = f;

api++;

}

}

if (mask & GLESv1_CM) {

ALOGD("GLESv1_CM loaded %s", driver_absolute_path);

init_api(dso, gl_names,

(__eglMustCastToProperFunctionPointerType*)

&cnx->hooks[egl_connection_t::GLESv1_INDEX]->gl,

getProcAddress);

}

if (mask & GLESv2) {

ALOGD("GLESv2 loaded %s", driver_absolute_path);

init_api(dso, gl_names,

(__eglMustCastToProperFunctionPointerType*)

&cnx->hooks[egl_connection_t::GLESv2_INDEX]->gl,

getProcAddress);

}

return dso;

}

初始化函数表主要通过 dlsym函数,根据函数名,一个个找到对应的地址,并赋值给函数指针来完成:

static void* load_wrapper(const char* path) {

void* so = dlopen(path, RTLD_NOW | RTLD_LOCAL);

ALOGE_IF(!so, "dlopen(\"%s\") failed: %s", path, dlerror());

return so;

}

② Android 加载 OpenGL ES总结

Android加载OpenGL ES流程图如图3.8所示:

从Android加载OpenGL ES的流程可以看出,只要Anbox在Android的/system/lib64/egl下安装对应的OpenGL ES库,则可以使Android加载Anbox提供的渲染库了。

Anbox在anbox/android/opengl/system下有几个文件夹,查看egl/Android.mk文件。

可以看到$(call emugl-begin-shared-library,libEGL_emulation),这一行的意思是编译为动态库,库名为libEGL_emulation。

Anbox中anbox/android文件夹是放在Android源码中,编译后存在Android镜像中,随着编译完成,Anbox在Android的/system/lib64/egl下就安装了三个动态库,分别为libEGL_emulation.so、libGLESv1_CM_emulation.so和libGLESv2_emulation.so。也就是Anbox作为虚拟的硬件厂商给Android提供的OpenGL ES渲染库。

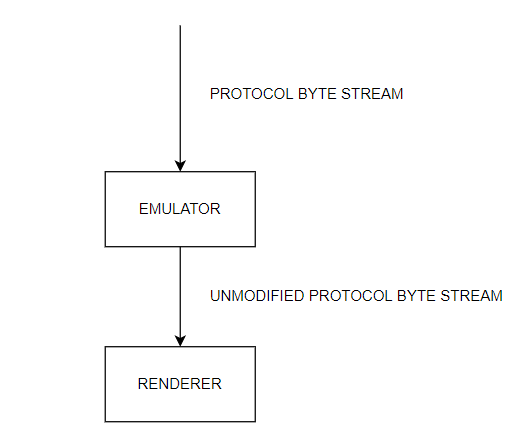

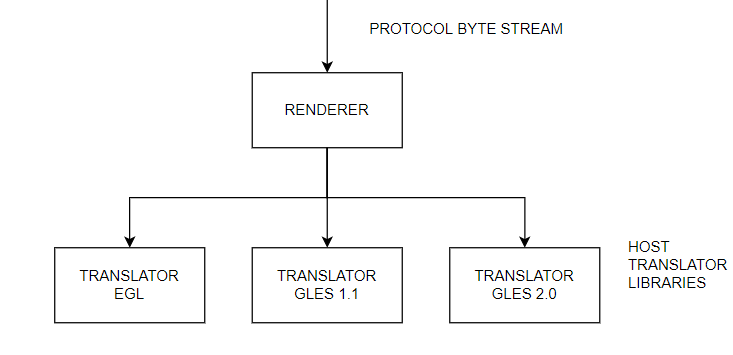

但Anbox实际渲染工作并不是上述三个库文件,这三个库文件作用为采集Android中APP渲染的OpenGL ES指令,并通过高速传输通道qemu-pipe传输将指令传至宿主机Anbox进程中,实际渲染工作由宿主机执行。 具体渲染的机制可以参考图3.9。

其中:swiftshader是谷歌提供的一种纯软件渲染的方式,其代码可在github进行搜索下载。

而host则是使用宿主机中默认的OpenGL ES库。即如果宿主机中显卡及显卡驱动支持OpenGL ES标准规范,则可以直接使用宿主机中的显卡进行渲染。但目前大部分显卡和驱动都不能直接支持OpenGL ES,因此Anbox会将Android的OpenGL ES 命令翻译成Linux所能支持的OpenGL 命令,再由Linux中的OpenGL进行渲染。

此部分代码在anbox/external/android-emugl和/anbox/src/anbox/graphics中。

3.2.3 Anbox接收与渲染

到这里,Android的OpenGL ES命令已经准备完成,接下来只要将指令发送给宿主机进行转换和渲染即可。

首先从Anbox源码入手进行分析,这一部分涉及到了渲染环境的初始化。

(1) 初始化:session manager入口

session manager的入口函数在anbox/src/anbox/cmds/session_manager.cpp.首先是处理一系列的启动参数,对渲染来说,主要参数是software-rendering

flag(cli::make_flag(cli::Name{"software-rendering"},

cli::Description{"Use software rendering instead of hardware accelerated GL rendering"}

使用软件渲染或硬件渲染:

const auto should_force_software_rendering = utils::get_env_value("ANBOX_FORCE_SOFTWARE_RENDERING", "false");

auto gl_driver = graphics::GLRendererServer::Config::Driver::Host;

if (should_force_software_rendering == "true" || use_software_rendering_)

gl_driver = graphics::GLRendererServer::Config::Driver::Software;

graphics::GLRendererServer::Config renderer_config {

gl_driver,

single_window_

};

auto gl_server = std::make_shared<graphics::GLRendererServer>(renderer_config, window_manager);

platform->set_window_manager(window_manager);

platform->set_renderer(gl_server->renderer());

window_manager->setup();

根据启动参数,决定使用软件渲染或硬件渲染,然后生成了一个GLRendererServer的共享指针,GLRendererServer函数信息位于anbox/src/anbox/graphics/gl_renderer_server.cpp中,源码为:

GLRendererServer::GLRendererServer(const Config &config, const std::shared_ptr<wm::Manager> &wm)

: renderer_(std::make_shared<::Renderer>()) {

std::shared_ptr<LayerComposer::Strategy> composer_strategy;

if (config.single_window)

composer_strategy = std::make_shared<SingleWindowComposerStrategy>(wm);

else

composer_strategy = std::make_shared<MultiWindowComposerStrategy>(wm);

composer_ = std::make_shared<LayerComposer>(renderer_, composer_strategy);

auto gl_libs = emugl::default_gl_libraries();

if (config.driver == Config::Driver::Software) {

auto swiftshader_path = fs::path(utils::get_env_value("SWIFTSHADER_PATH"));

const auto snap_path = utils::get_env_value("SNAP");

if (!snap_path.empty())

swiftshader_path = fs::path(snap_path) / "lib" / "anbox" / "swiftshader";

if (!fs::exists(swiftshader_path))

throw std::runtime_error("Software rendering is enabled, but SwiftShader library directory is not found.");

gl_libs = std::vector<emugl::GLLibrary>{

{emugl::GLLibrary::Type::EGL, (swiftshader_path / "libEGL.so").string()},

{emugl::GLLibrary::Type::GLESv1, (swiftshader_path / "libGLES_CM.so").string()},

{emugl::GLLibrary::Type::GLESv2, (swiftshader_path / "libGLESv2.so").string()},

};

}

emugl_logger_struct log_funcs;

log_funcs.coarse = logger_write;

log_funcs.fine = logger_write;

if (!emugl::initialize(gl_libs, &log_funcs, nullptr))

BOOST_THROW_EXCEPTION(std::runtime_error("Failed to initialize OpenGL renderer"));

renderer_->initialize(0);

registerRenderer(renderer_);

registerLayerComposer(composer_);

}

根据源码可知,先根据使用的窗口策略生成对应的图层合成策略智能指针,LayerComposer这个模块里面就是把不同应用的图层合成到同一个画布上,即虚拟一个Android的Surfaceflinger。

然后根据软件渲染还是硬件渲染读取对应的库函数,以软件渲染为例,Anbox先去读取swiftshader的环境变量,如果存在,则将swiftshader库的路径设置为环境变量读取到的路径;然后Anbox读取SNAP的环境变量,也就说,如果Anbox是使用snap打包启动的,则直接去对应的路径下读取swiftshader的库。如果读取到了swiftshader库的路径,则在对应路径下读取libEGL.so、libGLES_CM.so和libGLESv2.so。即OpenGL ES对应的三个库文件。

接着初始化这三个库文件,进入anbox/src/anbox/graphics/emugl/RenderApi.cpp:

bool initialize(const std::vector<GLLibrary> &libs, emugl_logger_struct *log_funcs, logger_t crash_func) {

set_emugl_crash_reporter(crash_func);

if (log_funcs) {

set_emugl_logger(log_funcs->coarse);

set_emugl_cxt_logger(log_funcs->fine);

}

for (const auto &lib : libs) {

const auto path = lib.path.c_str();

switch (lib.type) {

case GLLibrary::Type::EGL:

if (!init_egl_dispatch(path))

return false;

break;

case GLLibrary::Type::GLESv1:

if (!gles1_dispatch_init(path, &s_gles1))

return false;

break;

case GLLibrary::Type::GLESv2:

if (!gles2_dispatch_init(path, &s_gles2))

return false;

break;

default:

break;

}

}

打开对应路径,将egl需要用到的函数全部通过findSymbol或eglGetProcAddress的方式得到函数地址,方便后续直接调用。这样即可得到了OpenGL ES所有函数地址。

回到anbox/src/anbox/graphics/gl_renderer_server.cpp,初始化OpenGL函数后,会去初始化渲染器,来到了anbox/src/anbox/graphics/emugl/Renderer.cpp的initialize函数,其实就是在display :0上初始化OpenGL ES相关的环境。执行完相关函数后gl_renderer_server的初始化就完成了,回到anbox/src/anbox/cmds/session_manager.cpp,下一步window_manager->setup()创建本地窗口,其实就是Android窗口,所有Android的画面都会显示在这个窗口上。以单窗口为例,来到anbox/src/anbox/wm/single_window_manager.cpp

void SingleWindowManager::setup() {

if (auto p = platform_.lock()) {

window_ = p->create_window(0, window_size_, "Anbox - Android in a Box");

if (!window_->attach())

WARNING("Failed to attach window to renderer");

} else {

throw std::runtime_error("Can't create window as we don't have a platform abstraction");

}

}

先是创建了一个Window的对象,然后调用这个对象的attach函数,来到anbox/src/anbox/wm/window.cpp:

bool Window::attach() {

if (!renderer_)

return false;

attached_ = renderer_->createNativeWindow(native_handle());

return attached_;

}

可以看到,这里调用的renderer创建本地窗口。来到anbox/src/anbox/graphics/emugl/Renderer.cpp

RendererWindow *Renderer::createNativeWindow(

EGLNativeWindowType native_window) {

m_lock.lock();

auto window = new RendererWindow;

window->native_window = native_window;

window->surface = s_egl.eglCreateWindowSurface(

m_eglDisplay, m_eglConfig, window->native_window, nullptr);

if (window->surface == EGL_NO_SURFACE) {

delete window;

m_lock.unlock();

return nullptr;

}

if (!bindWindow_locked(window)) {

s_egl.eglDestroySurface(m_eglDisplay, window->surface);

delete window;

m_lock.unlock();

return nullptr;

}

s_gles2.glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT |

GL_STENCIL_BUFFER_BIT);

s_egl.eglSwapBuffers(m_eglDisplay, window->surface);

unbind_locked();

m_nativeWindows.insert({native_window, window});

m_lock.unlock();

return window;

}

(2) 指令传输与渲染

宿主机端

上文已经提到,Anbox的入口函数在session manage中 。代码位置anbox/src/anbox/cmds/session_manager.cpp:

auto qemu_pipe_connector =

std::make_shared<network::PublishedSocketConnector>(

utils::string_format("%s/qemu_pipe", socket_path), rt,

std::make_shared<qemu::PipeConnectionCreator>(gl_server->renderer(), rt));

Anbox建立了一个名字为qemu_pipe的unix socket服务端,并等待Android端连接。PublishedSocketConnector函数在anbox/src/anbox/network/published_socket_connector.cpp中,构造函数直接调用start_accept函数。

void PublishedSocketConnector::start_accept() {

auto socket = std::make_shared<boost::asio::local::stream_protocol::socket>(runtime_->service());

acceptor_.async_accept(*socket,

[this, socket](boost::system::error_code const& err) {

on_new_connection(socket, err);

});

}

当有客户端连接时则调用on_new_connection函数:

void

PublishedSocketConnector::on_new_connection

(std::shared_ptr<boost::asio::local::stream_protocol::socket> const& socket, boost::system::error_code const& err) {

if (!err)

connection_creator_->create_connection_for(socket);

if (err.value() == boost::asio::error::operation_aborted)

return;

start_accept();

}

这个函数的先是调用connection_creator中的create_connection_for函数,然后继续监听客户端连接。

这个connection_creator就是session manage 中传进来的qemu::PipeConnectionCreator。

查看anbox/src/anbox/qemu/pipe_connection_creator.cpp的create_connection_for函数

void PipeConnectionCreator::create_connection_for(

std::shared_ptr<boost::asio::local::stream_protocol::socket> const

&socket) {

auto const messenger = std::make_shared<network::LocalSocketMessenger>(socket);

const auto type = identify_client(messenger);

auto const processor = create_processor(type, messenger);

if (!processor)

BOOST_THROW_EXCEPTION(std::runtime_error("Unhandled client type"));

auto const &connection = std::make_shared<network::SocketConnection>(

messenger, messenger, next_id(), connections_, processor);

connection->set_name(client_type_to_string(type));

connections_->add(connection);

connection->read_next_message();

}

先是创建了一个LocalSocketMessenger,用来与客户端通信。然后通过函数identify_client判断客户端的类型,对于渲染来说,类型就是pipe:opengles。接着根据客户端类型创建对应的processor,最后再创建对应的connection 。创建完成后读取客户端消息。在创建processor时,会创建处理OpenGL ES指令的线程,在anbox/src/anbox/graphics/opengles_message_processor.cpp:

OpenGlesMessageProcessor::OpenGlesMessageProcessor(

const std::shared_ptr<Renderer> &renderer,

const std::shared_ptr<network::SocketMessenger> &messenger)

: messenger_(messenger),

stream_(std::make_shared<BufferedIOStream>(messenger_)) {

// We have to read the client flags first before we can continue

// processing the actual commands

unsigned int client_flags = 0;

auto err = messenger_->receive_msg(

boost::asio::buffer(&client_flags, sizeof(unsigned int)));

if (err) ERROR("%s", err.message());

render_thread_.reset(RenderThread::create(renderer, stream_.get(), std::ref(global_lock)));

if (!render_thread_->start())

BOOST_THROW_EXCEPTION(

std::runtime_error("Failed to start renderer thread"));

}

这里会创建一个线程render_thread专门来处理OpenGL ES的指令:

intptr_t RenderThread::main() {

RenderThreadInfo threadInfo;

ChecksumCalculatorThreadInfo threadChecksumInfo;

threadInfo.m_glDec.initGL(gles1_dispatch_get_proc_func, NULL);

threadInfo.m_gl2Dec.initGL(gles2_dispatch_get_proc_func, NULL);

initRenderControlContext(&threadInfo.m_rcDec);

ReadBuffer readBuf(STREAM_BUFFER_SIZE);

while (true) {

int stat = readBuf.getData(m_stream);

if (stat <= 0)

break;

bool progress;

do {

progress = false;

std::unique_lock<std::mutex> l(m_lock);

size_t last =

threadInfo.m_glDec.decode(readBuf.buf(), readBuf.validData(), m_stream);

if (last > 0) {

progress = true;

readBuf.consume(last);

}

last =

threadInfo.m_gl2Dec.decode(readBuf.buf(), readBuf.validData(), m_stream);

if (last > 0) {

progress = true;

readBuf.consume(last);

}

last = threadInfo.m_rcDec.decode(readBuf.buf(), readBuf.validData(), m_stream);